Introduction

Sorry, introdcution is currently available only in English

What is ToyVMM?

ToyVMM is a project being developed for the purpose of learning virtualization technology. ToyVMM aims to accomplish the following

Code-based understanding of KVM-based virtualization technologies Learn about the modern virtualization technology stack by using libraries managed by rust-vmm The rust-vmm libraries are also used as a base for well-known OSS such as firecracker and provides the functionality needed to create custom VMMs.

Disclaimer

While every effort has been made to provide correct information in this publication, the authors do not necessarily guarantee that all information is accurate. Therefore, the authors cannot be held responsible for the results of development, prototyping, or operation based on this information. If you find any errors in the contents of this document, please correct or report them as PR or Issue.

What's Next?

If you would like to try ToyVMM first, please refer to QuickStart. To learn more about KVM-based virtualization through ToyVMM, please refer to 01. Running Tiny Code in VM

QuickStart

Sorry, quickstart is currently available only in English

This quickstart documents are based on the commit ID of 58cf0f68a561ee34a28ae4e73481f397f2690b51.

Architecture & OS

ToyVMM only supports x86_64 Linux for Guest OS.

ToyVMM has been confirmed to work with Rocky Linux 8.6, 9.1 and Ubuntu 18.04, 22.04 as the Hypervisor OS.

Prerequisites

ToyVMM requires the KVM Linux kernel module.

Run Virtual Machine using ToyVMM

Following command builds toyvmm from source, downloads the kernel binary and rootfs needed to start the VM, and starts the VM.

# download and build toyvmm from source.

git clone https://github.com/aztecher/toyvmm.git

cd toyvmm

mkdir build

CARGO_TARGET_DIR=./build cargo build --release

# Download a linux kernel binary.

wget https://s3.amazonaws.com/spec.ccfc.min/img/quickstart_guide/x86_64/kernels/vmlinux.bin

# Download a rootfs.

wget https://s3.amazonaws.com/spec.ccfc.min/ci-artifacts/disks/x86_64/ubuntu-18.04.ext4

# Run virtual machine based on ToyVMM!

sudo ./build/release/toyvmm vm run --config examples/vm_config.json

After the guest OS startup sequence is output, the login screen is displayed, so enter both username and password as 'root' to login.

Disk I/O in Virtual Machine.

Since we have implemented virtio-blk, the virtual machine is capable of operating block devices.

Now it recognizes the ubuntu18.04.ext4 disk image as a block device and mounts it as the root filesystem.

lsblk

> NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

> vda 254:0 0 384M 0 disk /

Therefore, if you create a file in the VM and then recreate the VM using the same image, the file you created will be found. This behavior is significantly different from a initramfs (rootfs that is extracted on RAM).

# Create 'hello.txt' in VM.

echo "hello virtual machine" > hello.txt

cat hello.txt

> hello virtual machine

# Rebooting will cause the ToyVMM process to terminate.

reboot -f

# In the host, please restart VM and login again.

# Afterward, you can found the file you created in the VM during its previous run.

cat hello.txt

> hello virtual machine

Network I/O in Virtual Mahcine.

Since we have implemented virtio-net, the virtual machine is capable of operating network device.

Now, it recognizes the eth0 network interface.

ip link show eth0

> 2: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP mode DEFAULT group default qlen 1000

> link/ether 52:5f:7f:b3:f8:81 brd ff:ff:ff:ff:ff:ff

And toyvmm creates the host-side tap device named vmtap0 that connect to the virtual machine interface.

ip link show vmtap0

> 334: vmtap0: <BROADCAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UNKNOWN mode DEFAULT group default qlen 1000

> link/ether 26:e9:5c:02:3c:19 brd ff:ff:ff:ff:ff:ff

Therefore, by assigning appropriate IP addresses to the interfaces on both the VM side and the Host side, communication can be established between the HV and the VM.

# Assign ip address 192.168.0.10/24 to 'eth0' in vm.

ip addr add 192.168.0.10/24 dev eth0

# Assign ip address 192.168.0.1/24 to 'vmtap0' in host.

sudo ip addr add 192.168.0.1/24 dev vmtap0

# Host -> VM. ping to VM interface ip from host.

ping -c 1 192.168.0.10

# VM -> Host. Ping to Host interface ip from vm.

ping -c 1 192.168.0.1

Additionally, by setting the default route on the VM side, and configuring iptables and enabling IP forwarding on the host side, you can also allow the VM to access the Internet.

However, this will not be covered in detail here.

What's next?

If you are not familiar with KVM-based VMs, I suggest you start reading from 01. Running Tiny Code in VM. If not, please read the topics that interest you.

01. Running Tiny Code in VM

Sorry, this contents is currently available only in English

Tiny code execution is no longer supported in the current latest commit.

You may be able to verify it by checking out past commits, but please be aware that resolving package dependencies may be challenging.

This chapter is documented in a way that you can get a sense of its behavior without actually running it, so please feel reassured about that.

DeepDive ToyVMM instruction and how to run tiny code in VM

This main function is a program that starts a VM using the KVM mechanism and executes the following small code inside the VM

#![allow(unused)] fn main() { code = &[ 0xba, 0xf8, 0x03, /* mov $0x3f8, %dx */ 0x00, 0xd8, /* add %bl, %al */ 0x04, b'0', /* add $'0', %al */ 0xee, /* out %al, (%dx) */ 0xb0, '\n', /* mov $'\n', %al */ 0xee, /* out %al, (%dx) */ 0xf4, /* hlt */ ]; }

This code perform several register operations, but the initial state of the CPU regisers for this VM is set as follows.

#![allow(unused)] fn main() { regs.rip = 0x1000; regs.rax = 2; regs.rbx = 2; regs.rflags = 0x2; vcpu.set_sregs(&sregs).unwrap(); vcpu.set_regs(®s).unwrap(); }

This will output the result of calculations (2 + 2) inside the VM from the IO Port, followed by a newline code as well.

As you can see the result of running ToyVMM, hex value 0x34 (= '4') and 0xa (= New Line) are catched from I/O port

How's work above code with rust-vmm libraries

Now, the following crate provided by rust-vmm is used to run these codes.

# Please see Cargo.toml

kvm-bindings

kvm-ioctls

vmm-sys-util

vm-memory

I omit to describe about vmm-sys-util because it is only used to create temporary files at this point, so there is nothing special to mention about it.

I will go through the code in order and describe how each crate is related to that.

In this explanation, we will focus primary on the perspective of what ioctl is performed as a result of a function call (This is because the interface to manipulate KVM from the user space relies on the iocl system call)

Also, please note that explanations of unimportant variables may be omitted.

It should be noted that what is described here is not only the ToyVMM implementation, but also the firecracker implementation in a similaer form.

First, we need to open /dev/kvm and acquire the file descriptor. This can be done by Kvm::new() of kvm_ioctls crate. Following this process, the Kvm::open_with_cloexec function issues an open system call as follows, returns a file descriptor as Kvm structure

#![allow(unused)] fn main() { let ret = unsafe { open("/dev/kvm\0".as_ptr() as *const c_char, open_flags) }; }

The result obtained from above is used to call the method create_vm, which results in the following ioctl being issued

#![allow(unused)] fn main() { vmfd = ioctl(kvmfd, KVM_CREATE_VM, 0) where vmfd: from /dev/kvm }

Please keep in mind that the file descriptor returned from above function will be used later when preparing the CPU.

Anyway, we finish to crete a VM but it has no memory, cpu.

Now, the next step is to prepare memory!

In kvm_ioctls's example, memory is prepared as follows

#![allow(unused)] fn main() { // First, setup Guest Memory using mmap let load_addr: *mut u8 = unsafe { libc::mmap( null_mut(), mem_size, // 0x4000 libc::PROT_READ | libc::PROT_WRITE, libc::MAP_ANONYMOUS | libc::MAP_SHARED | libc::MAP_NORESERVE, -1, 0, ) as *mut u8 }; // Second, setup kvm_userspace_memory_region sructure using above memory // kvm_userspace_memory_region is defined in kvm_bindings crate let mem_region = kvm_userspace_memory_region { slot, guest_phys_addr: guest_addr, // 0x1000 memory_size: mem_size as u64, // 0x4000 userspace_addr: load_addr as u64, flags: KVM_MEM_LOG_DIRTY_PAGES, }; unsafe { vm.set_user_memory_region(mem_region).unwrap() }; // retrieve slice from pointer and length (slice::form_raw_parts_mut) // > https://doc.rust-lang.org/beta/std/slice/fn.from_raw_parts_mut.html // and write asm_code into this slice (&[u8], &mut [u8], Vec<u8> impmenent the Write trait!) // > https://doc.rust-lang.org/std/primitive.slice.html#impl-Write unsafe { let mut slice = slice::from_raw_parts_mut(load_addr, mem_size); slice.write(&asm_code).unwrap(); } }

Check set_user_memory_region. This function will issue the following ioctl as a result, attach the memory to VM

#![allow(unused)] fn main() { ioctl(vmfd, KVM_SET_USER_MEMORY_REGION, &mem_region) }

ToyVMM, on the other hand, provides a utility functions for memory preparation.

This difference is due to the fact that ToyVMM's implementation is similaer to firecracker's, but they are essentially doing the same thing.

Let's look at the whole implementation first

#![allow(unused)] fn main() { // The following `create_region` functions operate based on file descriptor, so first, create a temporary file and write asm_code to it. let mut file = TempFile::new().unwrap().into_file(); assert_eq!(unsafe { libc::ftruncate(file.as_raw_fd(), 4096 * 10) }, 0); let code: &[u8] = &[ 0xba, 0xf8, 0x03, /* mov $0x3f8, %dx */ 0x00, 0xd8, /* add %bl, %al */ 0x04, b'0', /* add $'0', %al */ 0xee, /* out %al, %dx */ 0xb0, b'\n', /* mov $'\n', %al */ 0xee, /* out %al, %dx */ 0xf4, /* hlt */ ]; file.write_all(code).expect("Failed to write code to tempfile"); // create_region funcion create GuestRegion (The details are described in the following) let mut mmap_regions = Vec::with_capacity(1); let region = create_region( Some(FileOffset::new(file, 0)), 0x1000, libc::PROT_READ | libc::PROT_WRITE, libc::MAP_NORESERVE | libc::MAP_PRIVATE, false, ).unwrap(); // Vec named 'mmap_regions' contains the entry of GuestRegionMmap mmap_regions.push(GuestRegionMmap::new(region, GuestAddress(0x1000)).unwrap()); // guest_memory represents as the vec of GuestRegion let guest_memory = GuestMemoryMmap::from_regions(mmap_regions).unwrap(); let track_dirty_page = false; // setup Guest Memory vm.memory_init(&guest_memory, kvm.get_nr_memslots(), track_dirty_page).unwrap(); }

The create_vm consequently performs a mmap in the following way and returns a part of the structure (GuestMmapRegion) representing the GuestMemory

#![allow(unused)] fn main() { pub fn create_region( maybe_file_offset: Option<FileOffset>, size: usize, prot: i32, flags: i32, track_dirty_pages: bool, ) -> Result<GuestMmapRegion, MmapRegionError> { ... let region_addr = unsafe { libc::mmap( region_start_addr as *mut libc::c_void, size, prot, flags | libc::MAP_FIXED, fd, offset as libc::off_t, ) }; let bitmap = match track_dirty_pages { true => Some(AtomicBitmap::with_len(size)), false => None, }; unsafe { MmapRegionBuilder::new_with_bitmap(size, bitmap) .with_raw_mmap_pointer(region_addr as *mut u8) .with_mmap_prot(prot) .with_mmap_flags(flags) .build() } }

Let's check the structure about Memory here.

In src/kvm/memory.rs, the following Memory structure is defined based on vm-memory crate

pub type GuestMemoryMmap = vm_memory::GuestMemoryMmap<Option<AtomicBitmap>>;

pub type GuestRegionMmap = vm_memory::GuestRegionMmap<Option<AtomicBitmap>>;

pub type GuestMmapRegion = vm_memory::MmapRegion<Option<AtomicBitmap>>;

The MmapRegionBuilder is also defined in the vm-memory crate, and this build method creates the MmapRegion.

This time, since we have performed the mmap myself in advance and passed that address to with_raw_mmap_pointer, use that area to initialize. Otherwise, mmap is performed in the build method. In any case, this build method will get the MmapRegion structure, but defines a synonym as described above, which is returned as the GuestMmapRegion. By calling the create_region function once, you can allocate and obtain one region of GuestMemory based on the information(size, flags, ...etc) specified in the argument.

The region allocated here is only mmapped from the virtual address space of the VMM process, and no further information is available. To use this area as Guest Memory, a GuestRegionMmap structure is created from this area. This is simple, specify the corresponding GuestAddress for this region and initialize GuestRegionMmap with a tuple of mmapped area and GuestAddress. In following code, the initialized GuestRegionMmap is pushed to Vec for subsequent processing.

#![allow(unused)] fn main() { map_regions.push(GuestRegionMmap::new(region, GuestAddress(0x1000)).unwrap()); }

Now, the mmap_regions: Vec<GuestRegionMmap> created as above represents the entire memory of the Guest VM, and each region that makes up the guest memory holds information on the area allocated by the VMM for the region and the top address of the Guest side.

The GuestMemoryMmap structure representing the Guest Memory is initialized from this Vec information and set to VM by the memory_init method.

#![allow(unused)] fn main() { let guest_memory = GuestMemoryMmap::from_regions(mmap_regions).unwrap(); vm.memory_init(&guest_memory, kvm.get_nr_memslots(), track_dirty_page).unwrap(); }

Next, let's check the operation of this memory_init. This calls set_kvm_memory_regions and the actual process is described there.

#![allow(unused)] fn main() { pub fn set_kvm_memory_regions( &self, guest_mem: &GuestMemoryMmap, track_dirty_pages: bool, ) -> Result<()> { let mut flags = 0u32; if track_dirty_pages { flags |= KVM_MEM_LOG_DIRTY_PAGES; } guest_mem .iter() .enumerate() .try_for_each(|(index, region)| { let memory_region = kvm_userspace_memory_region { slot: index as u32, guest_phys_addr: region.start_addr().raw_value() as u64, memory_size: region.len() as u64, userspace_addr: guest_mem.get_host_address(region.start_addr()).unwrap() as u64, flags, }; unsafe { self.fd.set_user_memory_region(memory_region) } }) .map_err(Error::SetUserMemoryRegion)?; Ok(()) } }

Here we can see that set_user_memory_region is called using the necessary information while iterating the region.

In other words, it is processing the same as the example code except that there may be more than one region.

Now that we've gone through the explanation of memory preparation, let's take a look at the vm-memory crate!

The information presented here is only the minimum required, so please refer to Design or other sources for more details.

This will also be related to the above iteration, where we were able to call methods such as sart_addr() and len() to construct the necessary information for set_user_memory_region.

#![allow(unused)] fn main() { GuestAddress (struct) : Represent Guest Physicall Address (GPA) FileOffset(struct) : Represents the start point within a 'File' that backs a 'GuestMemoryRegion' GuestMemoryRegion(trait) : Represents a continuous region of guest physical memory / trait GuestMemory(trait) : Represents a container for a immutable collection of GuestMemoryRegion object / trait MmapRegion(struct) : Helper structure for working with mmaped memory regions GuestRegionMmap(struct & implement GuestMemoryRegion trait) : Represents a continuous region of the guest's physical memory that is backed by a mapping in the virtual address space of the calling process GuestMemoryMmap(struct & implement GuestMemory trait) : Represents the entire physical memory of the guest by tracking all its memory regions }

Since GuestRegionMmap implements the GuestMemoryRegion trait, there are implementations of functions such as start_addr() and len(), which were used in the above interation.

The following figure briefly summarizes the relationship between these structures

As you can see, what is being done is essentially the same.

The final step is prepareing vCPU (vCPU is a CPU to be attached to a virtual machine).

Currently, a VM has been created and memory containing instructions has been inserted, but these is no CPU, so the instructions can't be executed. Therefore, let's create a vCPU, associate it with the VM, and execute the instruction by running the vCPU!

Using the file descriptor obtained during VM creaion (vmfd), the resulting ioctl will be issued as follows.

#![allow(unused)] fn main() { vcpufd = ioctl(vmfd, KVM_CREATE_VCPU, 0) }

The create_vm method that was just issued to obtain the vmfd is designed to return a kvm_ioctls::VmFd strucure as a result, and by execuing the create_vcpu method, which is a method of this structure, the above ioctl is consequently issued and returns the result as a kvm_ioctls::VcpuFd structure.

VcpuFd provides utilities for getting and setting various CPU states.

For example, if you want o get/set a register set from the vCPU, you would normally issue the following ioctl

#![allow(unused)] fn main() { ioctl(vcpufd, KVM_GET_SREGS, &sregs); ioctl(vcpufd, KVM_SET_SREGS, &sregs); }

For these, the following methods are available in kvm_ioctls::VcpuFd

#![allow(unused)] fn main() { get_sregs(&self) -> Result<kvm_sregs> set_sregs(&self, sregs: &kvm_sregs) -> Result<()> }

VcpuFd also provids a method called run, which issues the following insructions to actually run the vCPU.

#![allow(unused)] fn main() { ioctl(vcpufd, KVM_RUN, NULL) }

and then, we can aquire return values that has the type Result<VcpuExit> resulting this method.

When running vCPU, exit occurs for various reasons. This is an instruction that the CPU cannot handle, and the OS usually tries to deal with it by invoking the corresponding handler.

If this type of exit comes back from the VM's vCPU, as in the case, it will be necessary to write the appropriate code to handle the situation.

VcpuExit is defined in kvm_ioctls::VcpuExit as enum.

When Exit are occurred on several reasons in running vCPU, the exit reasons that are defined in kvm.h in linux kernel are wrapped to VcpuExit.

Therefore, it is sufficient to write a process that pattern matches this result and appropriately handles the error to be handled.

Now, there is a instruction that execute outputting values through I/O port and this will occur the KVM_EXIT_IO_OUT.

VcpuExit wrap this exit reason as IoOut.

Originally (in C programm as example), we require to calculate appropriate offset to get output data from I/O port, but now, this process are implemented in run method and returned as VcpuExit that contains necessary values.

So, we don't have to write these unsafe code (pointer offset calculation) and handle these exit as you will.

#![allow(unused)] fn main() { loop { match vcpu.run().expect("vcpu run failed") { kvm_ioctls::VcpuExit::IoOut(addr, data) => { println!( "Recieved I/O out exit. \ Address: {:#x}, Data(hex): {:#x}", addr, data[0], ); }, kvm_ioctls::VcpuExit::Hlt => { break; } exit => panic!("unexpected exit reason: {:?}", exit), } } }

In above, only handle KVM_EXIT_IO_OUT and KVM_EXIT_HLT, and the others will be processed as panic. (Although all exits should be handled, I want to focus on the description of KVM API example and keep it simply)

Since we are here, let's take a look at the processing of the run method in some detail.

Let's check the processing of KVM_EXIT_IO_OUT.

If you look at the LWN article, you will see that it calculates the offset and outputs the necessary information in the following way.

#![allow(unused)] fn main() { case KVM_EXIT_IO: if (run->io.direction == KVM_EXIT_IO_OUT && run->io.size == 1 && run->io.port == 0x3f8 && run->io.count == 1) putchar(*(((char *)run) + run->io.data_offset)); else errx(1, "unhandled KVM_EXIT_IO"); break; }

On the other hand, run method implemented in kvm_ioctl::VcpuFd is like bellow

#![allow(unused)] fn main() { ... let run = self.kvm_run_ptr.as_mut_ref(); match run.exit_reason { ... KVM_EXIT_IO => { let run_start = run as *mut kvm_run as *mut u8; // Safe because the exit_reason (which comes from the kernel) told us which // union field to use. let io = unsafe { run.__bindgen_anon_1.io }; let port = io.port; let data_size = io.count as usize * io.size as usize; // The data_offset is defined by the kernel to be some number of bytes into the // kvm_run stucture, which we have fully mmap'd. let data_ptr = unsafe { run_start.offset(io.data_offset as isize) }; // The slice's lifetime is limited to the lifetime of this vCPU, which is equal // to the mmap of the `kvm_run` struct that this is slicing from. let data_slice = unsafe { std::slice::from_raw_parts_mut::<u8>(data_ptr as *mut u8, data_size) }; match u32::from(io.direction) { KVM_EXIT_IO_IN => Ok(VcpuExit::IoIn(port, data_slice)), KVM_EXIT_IO_OUT => Ok(VcpuExit::IoOut(port, data_slice)), _ => Err(errno::Error::new(EINVAL)), } } ... }

Let me explain a little. The kvm_run is provided by the kvm-bindings crate, which is a structure automatically generated from a header file using bindgen, so it is a structure like the linux kernel's kvm_run converted directory to Rust.

First, kvm_run is obtained in the form of a pointer, a method of obtaining a pointer often used in Rust.

This correspoinds to the first address of the kvm_run structure which is bound to run_start variable.

And the information corresponding to run->io(.member) can be obtained from run.__bindgen_anon_1.io, although it is a bit tricky. The field named __bindgen_anon_1 is the effect of automatic generation by bindgen.

The data we want is at the first address of kvm_run plus io.data_offset. This process is performed in run_start.offset(io.data_offset as isize). And the data size can be calculated from io->size and io->count (in the LWN example, it is 1byte, so it's taken directory from the offset by putchar). This part is calculated and stored in the value data_size, and std::slice::from_raw_parts_mut actually retrieves the data using this size.

Finally, checking io.direction, we change the wrap type for KVM_EXIT_IO_IN or KVM_EXIT_IO_OUT respectively, and return the descired information such as port and data_slice together.

As can be seen from the above, what is being done is clear.

However, it still contains many unsafe operations because it involves pointer manipuration.

We can see that by using these libraries, we are able to implement VMM on a stable implementation.

Well, it's ben a long time comming, but let's take a look back at the rust-vmm crates we're using again.

#![allow(unused)] fn main() { kvm-bindings : Library that includes structures automatically generated from kvm.h by bindgen. kvm-ioctls : Library that hides ioctl and unsafe processes related to kvm operations and provides user-friendly sructures, functions and methods. vm-memory : Library that provides structures and operations to the Memory }

This knowledge will come up again and again in future discussion and is basic and important.

Load Linux Kernel

このセクションではVMMのファーストステップとしてGuest VMを起動するための実装について触れることとする。

VMMとしては必要最低限の機能である一方、Linux Kernelの起動にあたってさまざまな知識を要求される内容でもある。

このセクションではGuest VMを起動するための最低限の事項について説明し、ToyVMMでどのように実装しているかについても触れていく そのため、いくつかの細かいチャプターに分割しトピックごとに説明をしていくことにしよう

トピックとしては次のようになっている。

- 02-1. Overview of Booting Linux

- 02-2. ELF binary format and vmlinux structure

- 02-3. Loading initrd

- 02-4. Setup registers of vcpu

- 02-5. Serial Console implementation

- 02-6. ToyVMM implementation

また、本資料は以下のコミットナンバーをベースとしている

- ToyVMM :

27fdf196dfb31938f24785ca64e7233a6dc8fceb - Firecracker :

4bf121fc032cc2d94a20a3625f2af3918545154a

本資料をToyVMMのコードを参照しながら確認する場合は参考にされたい。

Overview of Booting Linux

一般的なブートの仕組み

Linuxでは大まかに以下のようにプログラムが順番に動作していくことでOSが起動していく

- BIOS

- ブートローダ (GRUB)

- Linuxカーネル(vmlinuz)

- init

BIOSはマザーボード上のROMにプログラムが格納されている。

我々が電源を投入すると、CPUはこの領域がマップされているアドレスから処理を実行するようになっている。

BIOSはハードウェアの検出、初期化を実行し、その後OSのブートドライブ(HHD/SSD、USBフラッシュメモリなど)を探索する。

この時、ブートドライブはMBR、もしくはGPTの形式でフォーマットされている必要があり、これらのフォーマットとBIOSの関係はそれぞれ以下のように対応する

| BIOS \ DISK Format | MBR | GPT |

|---|---|---|

| Legacy BIOS | ◯ | - |

| UEFI | ◯ * | ◯ |

* UEFIはLegacy Boot Modeのサポートがあるため、MBRをサポートしている

以降ではMBRを利用する場合のOS探索について説明する

詳しい説明に入る前に、MBRの構造について簡単に整理しておく。

以降で説明するMBRの構造はHDD/SSDやUSBフラッシュメモリなどの場合を想定し記載しており、後述するPartition Entryの存在を暗黙に仮定しているので注意されたい。

なお、本資料ではWikipediaで記載されている名称を引用しているので注意されたい。

MBRはブートドライブの先頭セクタに512byte書き込まれており、大きく分けて3つの領域が存在している。

- Bootstrap code are (446 byte)

- Partition Entry (64 byte = 16 byte * 4)

- Boot Signature (2 byte)

MBRについてここでは詳細に説明はしないが、Boot code areaにはOSをブートする機械語のプログラム(Boot Loader)が、Partition Entryにはそのディスクの論理パーティション情報が格納されている。

(余談だが、Boot code areaは446byteしかないため、Boot Loaderを直接実装するのではなく、Boot Loaderは別の場所に格納しておき、そのブートローダをメモリに読み込むために最小限のプログラムを配置することもあるようだ)

ここで重要なのは3つ目の「Boot Signature」であり、ここに格納されている2byteの値は、当該ドライブがブートドライブかどうかを担保するために利用される。

具体的には、BIOSがOSのブートドライブを探索する時、先頭1セクタ(512byte)を読み込み、最後の2byte(Boot Signature)がブートドライブであることを示すシグネチャ(0x55 0xaa)であることを確認する。

このシグネチャが亜確認できた場合、当該ディスクをブートディスクと判定し、先頭1セクタ(512byte)をメインメモリの0x7c00から0x7fffに読み込んで、0x7c00からプログラムを実行していく。

さて、これまでの議論の簡単な裏付けとして、手元のマシンでBoot Signatureを確認してみる。

仮想マシンなので、ブートディスクはvdaと表示されている。通常のマシンならsdaなどだろう。

このvdaから先頭1セクタ分の内容をファイルに書き出し、hexdumpで510byteオフセットした位置から2byte確認してみると、確かに0x55 0xaaの値が確認できる。

$ lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sr0 11:0 1 2M 0 rom

vda 252:0 0 300G 0 disk

├─vda1 252:1 0 1M 0 part

└─vda2 252:2 0 300G 0 part /

$ sudo dd if=/dev/vda of=mbr bs=512 count=1

1+0 records in

1+0 records out

512 bytes (512 B) copied, 0.000214802 s, 2.4 MB/s

$ hexdump -s 510 -C mbr

000001fe 55 aa |U.|

00000200

話を戻すと、BIOSによってMBRの情報を元にブートディスク上に格納されていたブートローダがメモリ上に展開され実行されていくことになる。ブートローダはカーネルとinitramfsをDISKからメモリに読み込み、カーネル起動する役目を持ったプログラムであり、近年では一般的にGRUBが利用されることが多い。ブートローダの詳細の処理内容についてもここでは省略とする。

重要な点としては、ブートローダはDISK上に格納されたカーネルなどを読み込む必要があるという点である。 これを達成する素朴な方法は我々がDISK上のカーネルファイルの位置をブートローダに対して教えることであろう。 しかしgrub.cfgの内容を見てみると、カーネルやinitrdの位置をファイルパスの形でしか指定していないことを確認できるだろう。 これはブートローダがファイルシステムを解釈する能力を有している必要があることを意味する。 実際に、Boot Loaderいくつかのファイルシステムを解釈でき、ファイルシステム上のディレクトリパス情報からカーネルを探し出すことができる。 ただし、当然ながらBoot Loaderは特定のファイルシステムのみのサポートに留まるため、それ以外のフォーマットのものを解釈することはできないので注意されたい。 ブートローダによってgrub.cfgで指定されたカーネルとRAMディスクをメモリ上にロードし、カーネルの先頭アドレスにジャンプすることで、処理をカーネルへと引き渡し自身の処理を終える

カーネルの処理の話に入る前に、カーネルファイルについて少し整理しておく。

カーネルファイルは一般にvmlinuz*という名前がついているファイルである

我々にとって馴染みのあるカーネルファイルは/boot/vmlinuz-*.imgと思われるが、このファイルはbzImage形式のファイルである。これはfileコマンドで簡単に確認することができる。

このbzImageはカーネル本体を含む圧縮バイナリファイルの他に、低レベルの初期化を行うためのファイルなどいくつかのファイルが含まれる形式になっている。

このbzImageを適切に解凍することでカーネルの実行バイナリを手に入れることもできる。

本資料ではbzImage形式のカーネルをvmlinuz、実行バイナリ形式のカーネルをvmlinux.binと表記する。

さてブートローダからvmlinuzに処理が引き渡されるとvmlinuzは低レベルの初期化処理を実施後、カーネル本体を解凍、メモリにロードし、カーネルのエントリールーチンに処理を移す。

カーネルは全ての初期化処理を終えると、tmpfsファイルシステムを作成し、ブートローダがRAM上に配置したinitramfsをそこに展開し、ディレクトリルートにあるinitスクリプトを起動する。

このinitスクリプトはDISK上に格納されている本命のファイルシステムをマウントするために必要な準備を整え、本命のファイルシステムやその他に重要なファイルシステムをマウントする。この時initramfsにはいくつかのデバイスドライバなども含まれているため、多様なフォーマットのルートファイルシステムをマウントすることが可能である。

さらにこれが完了すると、ルートを本命のルートファイルシステムに切り替え、そこに格納されている/sbin/init バイナリを起動する。

/sbin/initはシステムで最初に起動されるプロセス(PID=1が付与されるプロセス)であり、他のプロセスを起動させる役割を持っている全てのプロセスの親となるものである。

initにはさまざまな実装(SysVinit, Upstart)があるが、最近のCentOSやUbuntuなどで利用されているのはSystemdである。

initの最終的な責務は、システムの更なる準備とブートプロセスが終わった時点で必要なサービスが実行されておりユーザがログイン可能な状態まで持っていくことである。

以上が、非常に大雑把ではあるが電源投入からOSが起動するまでの流れである。

initrdとinitramfs

上記に記載したLinux起動処理の中に、メモリ上に展開するファイルシステムであるinitramfsを紹介したが、我々がよく目にするのは/boot/initrd.imgであろうと思う。ここではinitrdとinitramfsとの違いについて説明する

initrdは「initial RAM disk」、initramfs「initial RAM File System」であり両者は別物であるが、提供したい機能は同じで「本命のルートファイルシステムのマウントに必要なコマンド、ライブラリ、モジュール」を提供し、本命のルートファイルシステム上に存在する/sbin/initスクリプトを起動することである。

もともと本来起動したいシステムは何かしらの記憶装置に書き込まれているが、これを読み込むには適切なデバイスドライバの存在と、これをマウントするファイルシステムが存在していないといけないという問題がある。

initrd/initramfsは両方ともこの問題を解決する。

initrdとinitramfsは上記の機能を提供するための方式が異なっており、名前の通りであるがinitrdはブロックデバイス、initramfsは(tmpfsをもとにした)RAM filesystemの方式になっている。

従来はinitrdを利用していたが、Kernel 2.6以降でinitramfsが利用できるようになっており、現在はこちらの方式を利用することの方が一般的と思われる。

initrdからinitramfsに移りわってきたのにはもちろん、initrdには問題があり、initramfsはそれの解決が測られたからである。

initrdには概ね以下のような問題が存在していた

- RAM diskはRAM上に擬似的なブロックデバイスを作成し、これをあたかも二次記憶のように取り扱う仕組みであるため、通常のブロックデバイスと同様にメモリキャッシュ機構が働いてしまうために不必要にキャッシュメモリを消費する。さらにはページングのような機構が働いてしまうことで一層メモリを逼迫してしまう。

- RAM diskはそのデータをフォーマットし解釈するためのext2のようなファイルシステムドライバーが必要である。

- RAM diskのブロックデバイスは固定サイズになるため、あまりに小さいと必要なスクリプトを全て収めることができず、大きすぎると無駄にメモリを利用する

これを解決するために考案され、現在のデフォルトになっているのがinitramfsである。

initramfsはサイズを柔軟に設定できる軽量なメモリ内ファイルシステムであるtmpfsをベースとして作られたfilesystemである。

当然これはブロックデバイスではないので、キャッシュやページングでメモリを汚すこともなく、ブロックデバイスに対するファイルシステムドライバも不要で、さらに固定長という問題もうまく解決している。

initrd/initramfsいずれの方式にせよ、その中に格納されているツールを利用して本命のルートファイルシステムをマウントしそちらにルートを切り替えた上で、そのファイルシステム上に存在しているスタートアップスクリプトである/sbin/initを起動する。

initramfsの中身を確認する

initramfsの内容を展開し中身を確認してみる。Ubuntu 20.04.2 LTSのinitrdを展開してみる。

(注意: initrdという命名のファイルだが、このファイルはれっきとしたinitramfsである)。

initramfsはいくつかのファイルをCPIOの形式にしたものが連結されているため、そのままcpioコマンドで解凍しても以下のように冒頭のファイル(AuthenticAMD.bin)のみしか出てこない

$ mkdir initrd-work && cd initrd-work

$ sudo cp /boot/initrd.img ./

$ cat initrd.img| cpio -idvm

.

kernel

kernel/x86

kernel/x86/microcode

kernel/x86/microcode/AuthenticAMD.bin

62 blocks

dd/cpioの組み合わせで全てのファイルが展開できるが、unmkinitramfsという便利なコマンドがあるので今回はこちらを利用する

$ mkdir extract

$ unmkinitramfs initrd.img extract

$ ls extract

early early2 main

解凍した結果、early, early2, mainというディレクトリが作成されていることがわかる

例えばこのearlyは先ほどCPIOで解凍した際に出てきたファイルが確認できる

重要なのは、mainの配下で、その中のコンテンツとしてファイルシステムルートの内容が格納されている

$ ls extract/early/kernel/x86/microcode

AuthenticAMD.bin

$ ls extract/early2/kernel/x86/microcode

GenuineIntel.bin

$ ls extract/main

bin conf cryptroot etc init lib lib32 lib64 libx32 run sbin scripts usr var

ここで解凍した内容に対してchrootすると、Linux起動時のRAM filesystemの内容を擬似的に操作でき、どのような操作ができるか把握することができる。

$ sudo chroot extract/main /bin/sh

BusyBox v1.30.1 (Ubuntu 1:1.30.1-4ubuntu6.3) built-in shell (ash)

Enter 'help' for a list of built-in commands.

# ls

scripts init run etc var usr conf

lib64 bin lib libx32 lib32 sbin cryptroot

# pwd

/

# which mount

/usr/bin/mount

# exit

上記に示す通り、ルートにinitというスクリプトファイルが入っており、これがinitramfsを展開したのちに起動されるスクリプトである

このスクリプトを全て解説することはしないが、initスクリプトの中で/proc/cmdlineの中身を読んでおり、ここから本来のroot filesystemが格納しているディスク情報(root=/dev/sda1のような記載)を拾い、マウント処理を実施しているようであった。

一方、この辺りが空の場合、Ubuntu 20.04LTSのinitrdから抜き出したこのinitファイルではエラーになるようだった。

今回のToyVMMでは以降説明するfirecracker-initrdをベースとしたinitramfsを利用しているためこの辺りの挙動は少し異なる。

firecracker-initrdについて

ToyVMMでは、firecracker-initrdを利用させてもらっている。

firecracker-initrdはAlpineをベースとしてinitrd.img(initramfs)を作成してくれる。

上記でみたUbuntuのinitrdとは異なり、microcodeなど追加のCPIOファイルは含まれないため、単純に解凍するだけでroot filesystemが確認できる

$ cat initrd.img | cpio -idv

$ ls

bin dev etc home init initrd.img lib media mnt opt proc root run sbin srv sys tmp usr var

Alpine Linuxは通常起動時にRAM上にファイルシステムが展開された上でOSが起動する。その後ニーズに応じてsetup-alpineでDISKにOSを焼いたりするかなど決定する。

今回はこのAlpine Linuxのinitを使用しているため、このinitramfsを利用して起動したVMは、デフォルトでは本命のルートファイルシステムをマウントせず、単純にRAM上にファイルシステムを展開しAlpine Linuxが起動することになる。

これは、従来通りのOSのようにboot領域を二次記憶に置いた上で/proc/cmdlineでinitスクリプトに伝えるという流れとは異なるものであるということを理解しておきたい。

Boot sequence of linux kernel in ToyVMM

ここでこれまで議論してきた内容とToyVMMでのLinuxブートについての比較をしてみる

| Boot process (on Linux) | ToyVMM |

|---|---|

| BIOS | Not implemented yet |

| Boot Loader | Require: vmlinux/initrd.img loading, basic setup required |

| Linux Kernel | Processed by vmlinux.bin |

| init | Processed by init scripts (from firecracker-initrd's initrd.img) |

現在のToyVMMの実装ではbzImageの読み込みについてはサポートしておらず、ELFバイナリであるvmlinux.binを利用することとする。

現時点の実装ではBIOS関係については実装を省略している。

BootLoaderが行う処理のうち、vmlinux.binやinitrd.imgをメモリにロードするなどの処理を実装する必要がある。

Linux Kernel自体はvmlinux.binが、initの処理はinitrd.img内部のinitスクリプトが担当するため、上記の処理を実装することで既存のLinux Kernelを起動すること自体は可能である。

より詳細の実装については02-6_minimal_vmm_implementationで説明する。

References

- MBR(Master Boot Records)の構造

- Initrd(4) - Linux man page

- Initramfsのしくみ

- Initramfs/ガイド

- Kernel Boot Process

- What's the Difference Between initrd and initramfs

- bzImage

- Initデーモンを理解する

- Linuxがブートするまで

- filesystems/ramfs-rootfs-initramfs.txt

ELF binary format and vmlinux structure

本稿執筆時、ToyVMMでVMを起動する際に利用するカーネルはELF形式のvmlinux.binを前提としている。

そのため、VMMの内部ではELF形式を解釈し、適切にカーネルをVM用に用意したメモリ領域にロードする必要がある。

この処理は rust-vmm/linux-loader crateで実装されており、ToyVMMではこのcrateを利用するため実装としては隠蔽されてしまうが、このcrateの中でどのように処理されているかを知ることは重要だと判断したため、本章を設けELFバイナリのロードに関する解説を記載することとした。

ELF Binary Format

ELFのファイルフォーマットは以下のようになっている

上記の通り、ELFファイルフォーマットは基本的にELF Header、Program Header Table、Segument(Sections)、Section Header Tableからなる。

ELFファイルはシステムローダが利用する場合はProgram Header Tableに記述されたSegmentの集合として取り扱われ、コンパイラ・アセンブラ・リンカはSection Header Tableに記述されたSectionの集合として扱われる。

ELF HeaderはこのELFファイルの全体的な情報を保持している。

Program Header Tableの各エントリであるProgram Headerは、それぞれが対応するSegumentについてのHeader情報を保持している。つまり、Program Headerの数だけ、Segmentが存在していることになる。

また、このSegumentはさらに複数のSecitonという単位に分割でき、このSection単位でヘッダ情報を保持しているのがSection Header Tableである。

ELF Headerは常にファイルオフセットの先頭から始まっており、ELFデータを読み込むために必要となる情報を保持している。

以下にELF Headerの内容を一部抜粋する。全体の構成を知りたい場合はMan page of ELFを参考にされたい

| Attribute | Meaning |

|---|---|

e_entry | このELFプロセスを開始する際のエントリポイントとなる仮想アドレス |

e_phoff | Program Header Tableが存在する場所のファイルオフセット値 |

e_shoff | Section Header Tableが存在する場所のファイルオフセット値 |

e_phentsize | Program Header Tableにある1エントリのサイズ |

e_phnum | Program Header Table中のエントリの個数 |

e_shentsize | Section Header Tableにある1エントリのサイズ |

e_shnum | Section Header Table中のエントリの個数 |

上記で抜粋した内容から、Program HeaderやSection Headerの各エントリの情報を取り出すことが可能であると分かるであろう。

ここで、Program Headerの内容を一部抜粋する。

| Attribute | Meaning |

|---|---|

p_type | このProgram Headerが指すSegmentの種類を表現しており、解釈の方法についてのヒントを与える |

p_offset | このProgram Headerが指すSegmentのファイルオフセット値 |

p_paddr | 物理アドレスが意味を持つシステムでは、この値はProgram Headerが指すSegmentの物理アドレスを指す |

p_filesz | このProgram Headerが指すSegmentのファイルイメージのバイト数 |

p_memsz | このProgram Headerが指すSegmentのメモリイメージのバイト数 |

p_flags | このProgram Headerが指すSegmentの情報を示すフラグで、実行可能、書き込み可能、読み取り可能を表現している |

上述の通り、Program Headerの中身を解釈することで、当該セグメントの位置やサイズ、どの様に解釈すべきかの情報を手に入れることができる。

今回の内容はこのProgram Headerの構造まで把握できていれば十分であるため、Section Headerやそのほかの詳細については省略する。

興味がある方は、Man page of ELF等を参考に確認されたい。

さて、後述するが今回取り扱うvmlinux.binはProgram Headerの数が5個で、内4つのp_typeの値がPT_LOAD、最後の一つだけPT_NOTEになっているという大変簡単な構造になっている。

ここで、PT_LOAD、PT_NOTEについてのみ、Man page of ELFからその詳細内容を部分的に抜粋する。一部情報を削っているため、必要に応じて参考資料を確認されたい。

p_type | Meaning |

|---|---|

PT_LOAD | この要素はp_fileszとp_memszで記述される読み込み可能なSegmentである。 |

PT_NOTE | この要素はロケーションとサイズのための補助情報が書き込まれている |

PT_LOADでは、ファイルのバイト列はメモリセグメントの先頭に対応づけされているため、p_offsetを利用して得られる、セグメントのメモリアドレスからサイズ分(基本的にはp_memszを利用する)をCOPYすることでセグメントの内容を読み込むことができる。

以上で必要最低限なELFの知識を身につけることができたので、次は実際にvmlinux.binをダンプしてみて中身を確認してみる。

vmlinxの解析

それではここでvmlinuxの内容を少し解析してみよう。

この解析内容の一部は今後重要な要素になってくるため是非把握してもらいたい。

readelfコマンドはELFフォーマットのファイルを理解しやすい形でダンプしてくれる非常に心強いツールである。

ここではvmlinuxのELF Header(-h)、Program Header(-l)をそれぞれ表示してみる

$ readelf -h -l vmlinux.bin

ELF Header:

Magic: 7f 45 4c 46 02 01 01 00 00 00 00 00 00 00 00 00

Class: ELF64

Data: 2's complement, little endian

Version: 1 (current)

OS/ABI: UNIX - System V

ABI Version: 0

Type: EXEC (Executable file)

Machine: Advanced Micro Devices X86-64

Version: 0x1

Entry point address: 0x1000000

Start of program headers: 64 (bytes into file)

Start of section headers: 21439000 (bytes into file)

Flags: 0x0

Size of this header: 64 (bytes)

Size of program headers: 56 (bytes)

Number of program headers: 5

Size of section headers: 64 (bytes)

Number of section headers: 36

Section header string table index: 35

Program Headers:

Type Offset VirtAddr PhysAddr

FileSiz MemSiz Flags Align

LOAD 0x0000000000200000 0xffffffff81000000 0x0000000001000000

0x0000000000b72000 0x0000000000b72000 R E 0x200000

LOAD 0x0000000000e00000 0xffffffff81c00000 0x0000000001c00000

0x00000000000b0000 0x00000000000b0000 RW 0x200000

LOAD 0x0000000001000000 0x0000000000000000 0x0000000001cb0000

0x000000000001f658 0x000000000001f658 RW 0x200000

LOAD 0x00000000010d0000 0xffffffff81cd0000 0x0000000001cd0000

0x0000000000133000 0x0000000000413000 RWE 0x200000

NOTE 0x0000000000a031d4 0xffffffff818031d4 0x00000000018031d4

0x0000000000000024 0x0000000000000024 0x4

Section to Segment mapping:

Segment Sections...

00 .text .notes __ex_table .rodata .pci_fixup __ksymtab __ksymtab_gpl __kcrctab __kcrctab_gpl __ksymtab_strings __param __modver

01 .data __bug_table .vvar

02 .data..percpu

03 .init.text .altinstr_aux .init.data .x86_cpu_dev.init .parainstructions .altinstructions .altinstr_replacement .iommu_table .apicdrivers .exit.text .smp_locks .data_nosave .bss .brk

04 .notes

ELF Headerをみてみると、Entry point address (e_entry)の値としてProgram Headerの最初のセグメントの物理アドレスの値である(0x0100_0000)が格納されていることが分かる。この値はrust-vmm/linux-loaderの実装としてkernelをロードした際の返り値として返却される値であり、かつvCPUのeip(命令アドレスレジスタ)に設定する値でもあるため重要である。

また、ELF HeaderのNumber of program headers(e_phnum)の値である5と同じ数のProgram Headerが確認でき、Program Headerを出力をみると先頭4つはTypeがLOAD、最後はNOTEとなっていることが確認できる。

また、1つ目、および4つ目のLOADセグメントはFlagを確認するとE(xecutable)がマークされており、この辺りに実行可能コードが存在していることも分かる。

特に1つめのエントリは実際にカーネルの実行バイナリのエントリポイントに該当する内容が配置されていることが期待される。

今回はこれ以上の深追いは控えておくが、興味がある人はELFのSpecificationをもとにさらに解析をしてみるのも面白いかもしれない。

ToyVMMでの実装

ToyVMMでは、src/builder.rsの中のload_kernel関数の中でvmlinuxの読み込みを実施している。

この関数には、カーネルファイルへのパス情報などが含まれているboot_configとVM向けに確保したメモリ(guest_memory)を渡している。

load_kernelが実施していることは単純で、boot_configからカーネルファイルへのパスを取得し、linux-loaderのElfという構造体をLoaderという名前で取り扱い、この構造体に実装されているELF形式のLinuxのローディング処理を適切な引数を伴って実行しているだけである。

use linux_loader::elf::Elf as Loader;

let entry_addr = Loader::load::<File, memory::GuestMemoryMmap>(

guest_memory,

None,

&mut kernel_file,

Some(GuestAddress(arch::x86_64::get_kernel_start())),

).map_err(StartVmError::KernelLoader)?;

さて、ここからlinux-loaderの実装について深掘りしてみよう。

linux-loaderでは、KernelLoader traitが定義されており、その定義は以下のようになっている

/// Trait that specifies kernel image loading support.

pub trait KernelLoader {

/// How to load a specific kernel image format into the guest memory.

///

/// # Arguments

///

/// * `guest_mem`: [`GuestMemory`] to load the kernel in.

/// * `kernel_offset`: Usage varies between implementations.

/// * `kernel_image`: Kernel image to be loaded.

/// * `highmem_start_address`: Address where high memory starts.

///

/// [`GuestMemory`]: https://docs.rs/vm-memory/latest/vm_memory/guest_memory/trait.GuestMemory .html

fn load<F, M: GuestMemory>(

guest_mem: &M,

kernel_offset: Option<GuestAddress>,

kernel_image: &mut F,

highmem_start_address: Option<GuestAddress>,

) -> Result<KernelLoaderResult>

where

F: Read + Seek;

}

コメントから推測できるように、このtraitが実装しているべきload関数は、特定のカーネルイメージフォーマットをGuestMemoryに読み込むような実装になっていることを要求している。

linux-loaderではx86_64向けの実装として、ELF形式の他にbzImage形式のカーネルの読み込みについても実装が存在しているようであるが、ひとまず今回はELF向けの実装を利用する。

さて、先のToyVMM側のコードで利用していたElf構造体(Loaderと名前を変えてimportした構造体)はこのKernelLoader traitを実装しており、そのload関数がELFファイルをロードする実装になっていることが期待できる。

そのため、このload関数を見てみると以下のような処理になっていることがわかる。処理内容がすこし長いためコードの転載は控える。

- ELFファイルの先頭から、ELFヘッダー分のデータを抜き出す

loader_resultという変数名のKernelLoaderResult構造体のインスタンスを作成し、kernel_loadメンバにELFヘッダのe_entryの値を格納しておく。この値はシステムが最初に制御を渡すアドレス、つまりプロセスを開始する仮想アドレスに該当する。- ELFファイルを先頭からプログラムヘッダテーブルが存在するアドレスまで(

e_phoff分)シークし、プログラムヘッダテーブル数分(e_phnum分)ループしながら、ELFファイルに含まれているプログラムヘッダを全て抜き出す。 - 上記のプログラムヘッダをループしつつ以下の内容を行う

- ELFファイルの先頭から今確認しているプログラムヘッダに対応するセグメントまで(

p_offset分)シーク - Guestのメモリに対して、

mem_offsetから算出したmemory regionのアドレス位置を先頭に、kernel_image(p_offset分シーク済みなので、プログラムヘッダに対応するセグメントのデータの先頭)から、セグメントのサイズ分(p_filesz分)だけを書き込む kernel_end(GuestMemory上での読み込んだセグメントの末尾のアドレス)の値を更新し、loader_result.kernel_end(2回目以降のループでは前回の値が記録されている)と比較して大きい方の値をloader_result.kernel_endに格納しておく

- ELFファイルの先頭から今確認しているプログラムヘッダに対応するセグメントまで(

- 全てのプログラムヘッダをループ後、返り値として最終的な

loader_resultを返却する。

これはまさに上記でみたELFフォーマットを解釈し読み込むコードになっていることがわかる。

また当該関数呼び出しの結果返却されるKernelLoaderResultの値には、最終的なGuestMemory上でのカーネルの開始位置、終了位置の情報が含まれており、特にこの開始位置の情報はSetup registers of vCPUで利用する値になるため重要である。

References

Loading initrd

本稿では、VMを起動するにあたりinitrd(initramfs)のロードやこれにまつわる設定について記載する。

以降の記載では、initrdと書いたときも暗黙にinitramfsを指しているとする。

initramfs自体の説明はOverview of booting linuxで既におこなっているのでそちらを確認されたい

Loading initrd and setup some parameters of kernel header

initrdをロードする関数はload_initrdに実装している。

引数としてはGuest用に確保したメモリと、initrdのファイルをOpenしたFile構造体(Read, Seekを実装している)の可変参照を渡している

#![allow(unused)] fn main() { fn load_initrd<F>( vm_memory: &memory::GuestMemoryMmap, image: &mut F, ) -> std::result::Result<InitrdConfig, StartVmError> where F: Read + Seek { let size: usize; // Get image size match image.seek(SeekFrom::End(0)) { Err(e) => return Err(StartVmError::InitrdRead(e)), Ok(0) => { return Err(StartVmError::InitrdRead(io::Error::new( io::ErrorKind::InvalidData, "Initrd image seek returned a size of zero", ))) } Ok(s) => size = s as usize, }; // Go back to the image start image.seek(SeekFrom::Start(0)).map_err(StartVmError::InitrdRead)?; // Get the target address let address = arch::initrd_load_addr(vm_memory, size) .map_err(|_| StartVmError::InitrdLoad)?; // Load the image into memory // - read_from is defined as trait methods of Bytes<A> // and GuestMemoryMmap implements this trait. vm_memory .read_from(GuestAddress(address), image, size) .map_err(|_| StartVmError::InitrdLoad)?; Ok(InitrdConfig{ address: GuestAddress(address), size, }) } }

上記の処理でおこなっていること関数名の通りGuest用メモリへのinitrdのロードであるが、内容としては以下の通り単純である

- initrdのサイズの取得する(SeekFrom::End(0)としてファイルの末尾にカーソルを指定することでoffset=size取得をしている)

- 1でサイズを取得するために動かしたカーソルを先頭に戻す

- initrdをロードするべきGuestメモリのaddressを取得する

- 上記Guestメモリのaddress位置にinitrdの中身を読み込む

InitrdConfigという構造体にGuestメモリのinitrd開始位置のアドレスとinitrdの値を詰めて返却する)

さて、上記でGuestメモリ上にinitrdをロードすることはできたが、実際にこの領域をカーネルがどのように把握するのかという疑問が残っている

ブートローダの責務の一つにカーネルのセットアップヘッダを読み込み、いくつかのフィールドを埋めるというものがある。

このセットアップヘッダの内容はBoot Protocolとして定義されており、上記のinitrdに関係する内容はこの値として格納されるべき値の一つになっている.

今回、ToyVMMではこれらの内容を主にconfigure_system関数で以下の通り設定している。

以下の内容についてはBoot Protocolを参照している。

ここでは下記以外の設定項目については設定をしていないため説明を省略する。

| Offset/Size | Name | Meaning | ToyVMM value |

|---|---|---|---|

| 01FE/2 | boot_flag | 0xAA55 magic number | 0xaa55 |

| 0202/4 | header | Magic signature "HdrS" (0x53726448) | 0x5372_6448 |

| 0210/1 | type_of_loader | Boot loader identifier | 0xff (undefined) |

| 0218/4 | ramdisk_image | initrd load address (set by boot loader) | GUEST ADDRESS OF INITRD |

| 021C/4 | ramdisk_size | initrd size (set by boot loader) | SIZE OF INITRD |

| 0228/4 | cmd_line_ptr | 32-bit pointer to the kernel command line | 0x20000 |

| 0230/4 | kernel_alignment | Physical addr alignment required for kernel | 0x0100_0000 |

| 0238/4 | cmdline_size | Maximum size of the kernel command line | SIZE OF CMDLINE STRING |

上記の内容をGuestMemoryの0x7000に書き込むコードになっている。

この0x7000のアドレスは後述するvCPUのRSIの値として書き込んでおく値になる。

vCPUのレジスタ設定関係についてはSetup registers of vCPUに記載しているので、本稿読了後に参照されたい。

Setup E820

Guest OSのE820のセットアップを行うことで、OSやBootLoaderに対して利用可能なメモリ領域の報告できるようにしたい。 この辺りの処理は基本的にFirecrackerの実装に合わせて実装している。

#![allow(unused)] fn main() { add_e820_entry(&mut params, 0, EBDA_START, E820_RAM)?; let first_addr_past_32bits = GuestAddress(FIRST_ADDR_PAST_32BITS); let end_32bit_gap_start = GuestAddress(MMIO_MEM_START); let himem_start = GuestAddress(HIGH_MEMORY_START); let last_addr = guest_mem.last_addr(); if last_addr < end_32bit_gap_start { add_e820_entry( &mut params, himem_start.raw_value() as u64, last_addr.unchecked_offset_from(himem_start) as u64 + 1, E820_RAM)?; } else { add_e820_entry( &mut params, himem_start.raw_value(), end_32bit_gap_start.unchecked_offset_from(himem_start), E820_RAM)?; if last_addr > first_addr_past_32bits { add_e820_entry( &mut params, first_addr_past_32bits.raw_value(), last_addr.unchecked_offset_from(first_addr_past_32bits) + 1, E820_RAM)?; } } }

上記のコードはToyVMMで起動するGuest VMのアドレス全体の設計を見ながら理解した方が良いだろう。そのため以下に、現状の実装におけるGuestのメモリ設計を以下の通り一覧にしておく。 この内容は今後変更される可能性があるため注意されたい。

| Guest Address | Contents | Note |

|---|---|---|

| 0x0 - 0x9FBFF | E820 | |

| 0x7000 - 0x7FFF | Boot Params (Header) | ZERO_PAGE_START(=0x7000) |

| 0x9000 - 0x9FFF | PML4 | Now only 1 entry (8byte), maybe expand later |

| 0xA000 - 0xAFFF | PDPTE | Now only 1 entry (8byte), maybe expand later |

| 0xB000 - 0xBFFF | PDE | Now 512 entry (4096byte) |

| 0x20000 - | CMDLINE | Size depends on cmdline parameter len |

| 0x100000 | HIGH_MEMORY_START | |

| 0x100000 - 0x7FFFFFF | E820 | |

| 0x100000 - 0x20E3000 | vmlinux.bin | Size depends on vmlinux.bin's size |

| 0x6612000 - 0x7FFF834 | initrd.img | Size depends on initrd.img's size |

| 0x7FFFFFF | GuestMemory last address | based on (128 << 20 = 128MB = 0x8000000) - 1 |

| 0xD0000000 | MMIO_MEM_START(4GB - 768MB) | |

| 0xD0000000 - 0xFFFFFFFF | MMIO_MEM_START - FIRST_ADDR_PAST_32BIT | |

| 0x100000000 | FIRST_ADDR_PAST_32BIT (4GB~) |

コードを確認すると、GuestMemoryのサイズに非依存で設計しているアドレス帯(大まかに0x0 ~ HIGH_MEMORY_STARTのレンジ)は0~EBDA_START(0x9FBFF)の領域を共通でE820にUsableで登録している。

その後、GuestMemoryをどの程度確保しているかに従ってE820に登録している範囲が変化する。

現在の実装では、GuestのMemoryはデフォルトで128MBのメモリを確保するように実装しているためGuest Memoryは全体で0x0 ~ 0x7FF_FFFFになる。今回はこのレンジにvmlnux.binの内容やinitrd.imgがマップされている。

つまりguest_mem.last_addr() = 0x7FF_FFFF < 0xD000_0000 = end_32bit_gap_startのロジックに該当するので、HIGH_MEMORY_START ~ guest_mem.last_addr()のレンジを追加で登録している。

今後拡張していく中で、GuestMemoryのサイズが4GB超える場合は、0x10_0000 ~ 0xD000_0000と0x1_000_0000 ~ guest_mem.last_addr()のレンジを登録することになる。

後ほどVM起動時のコンソール出力を確認できるようになるが、ここでは確認のために先取ってVM起動時の一部の出力を添付する。 以下のように上記で設定したE820エントリが登録できている。

[ 0.000000] e820: BIOS-provided physical RAM map:

[ 0.000000] BIOS-e820: [mem 0x0000000000000000-0x000000000009fbff] usable

[ 0.000000] BIOS-e820: [mem 0x0000000000100000-0x0000000007ffffff] usable

References

- Linuxのブートシーケンスの基礎まとめ

- Linuxカーネルユーザ・管理者ガイド - 初期RAMdディスクを使用する

- initrd

- initramfs(initrd)のinitをbusyboxだけで書いてみた

- initramfsとinitrdについて

- initramfsについて

- filesystem/ramfs-rootfs-initramfs.txt

Setup registers of vCPU

本稿では、vCPUのレジスタの設定について記載する。

一口にレジスタと言ってもその種類は多岐に渡るため、それぞれどのレジスタをどう設定すると良いかを判断するのはかなり煩雑である。

本稿で説明するRegisterに関わる内容はVMを起動するという側面にのみ焦点を置いた内容になっているので注意されたい。

また、64-bit modeでGuest OSを起動したいので、64-bit modeに移行するためのいくつかの設定やその設定にまつわるPagingについても簡単に解説する。

Setup vCPU general purpose registers

vCPUのgeneral purose registersは、KVMのset_regs APIを通してセットアップが可能である。

今回は以下のようにレジスタの値を設定する。(レジスタ自体の詳細な説明は省く)

| Register | Value | Meaning |

|---|---|---|

| RFLAGS | 2 | 0x02のbitは予約ビットで立てておかないといけない |

| RIP | KERNEL START ADDRESS (0x0100_0000) | ELFから取得したkernelのentry pointのアドレス |

| RSP | BOOT STACK POINTER (0x8ff0) | BOOT時に利用するStack Pointerのアドレス |

| RBP | BOOT STACK POINTER (0x8ff0) | BOOT処理実施前なのでRSPの値に合わせておく |

| RSI | boot_params ADDRESS (0x7000) | boot_paramの情報が格納されているアドレス |

RIPはvCPU起動時の命令開始アドレスを格納する必要があり、今回はKernelのEntry Pointのアドレスを記載する。

後述するが、x64 Long Modeを設定したCPUで実行するため、RIPのアドレスも仮想メモリアドレスとして扱われることになるが、Paging機構をIdentity Mappingで実装するため、仮想メモリアドレス = 物理メモリアドレスとなり辻褄が合うことになる。

RSP、RBPにはBootに必要なStackを格納するためのアドレスを入れておく。この辺りの値は空いている領域を使えば良い

RSIには64-bit Boot Protocolにも記載がある通り、boot_params構造体が格納されているアドレスを渡しておく必要がある。

ToyVMMはFirecrackerの値を模倣して作成しているため、RSP、RBP、RSIに格納するaddress値はFirecrackerのものを模倣している。

Setup vCPU special registers

vCPUのspecial registersは、KVMのset_sregs APIを通してセットアップが可能である。

ここでは実際にセットアップをしているレジスタにのみ焦点を当てつつ、その背景についても簡単にではあるが触れながら確認していく。

ここからの説明では、これまで話題に上げてこなかった単語なども出てくることになるだろう。これらを一つ一つ説明していてはキリがないため、知らない単語に遭遇したらご自身で確認してほしい。

IDT(Interrupt Descriptor Table)

IDT(Interrupt Descriptor Table)とは、Protected modeとLong Modeにおける割り込み、例外に関する情報を保持するデータ構造である。

もともとReal ModeではIVT(Interrupt Vector Table)というものが存在しており、これはISR(Interrupt Service Routine)がどこにあるかをCPUに対して教える役割を持っていた。

要するに各割り込みや例外に対するハンドラを保持しており、それらが発生したとき、どのハンドラを起動すればいいか決定できるテーブルであった。

Protected modeやLong modeになるとRead Modeとは異なるアドレス表現になるため、それに対応した同様の能力をもつ機構がIDTである。

IDTは最大255 Entryのテーブルであり、IDTのアドレスをIDTRレジスタに設定する必要がある。割り込みが発生した際、CPUはIDTRの値からIDTを参照し、指定された割り込みハンドラを実行する。

64-bit Boot Protocolでの要求を確認すると、Interruptの設定はDisabledでなくてはならないという。 それに伴い、IDTに関する設定はToyVMM(Firecracker)の実装の中では省略されている、IDTについての説明もここまでにとどめておく。

Segumentation, GDT(Global Descriptor Table), LDT(Local Descriptor Table)

GDTの話を始める前に、まずはSegumentationについて軽く導入しておく。

メモリセグメンテーションはメモリ管理方式の一つであり、プログラムやデータをセグメントと呼ばれる可変なまとまりで管理する方式である。

セグメントはメモリ空間上で情報の属性などによって分類されたグループであり、仮想記憶やメモリ保護機能を実現する方式の一つである。

Linuxではフラットメモリを前提としたセグメンテーションとPagingを併用しているため、以降ではそれを前提として話を進める。

GDT(Global Descriptor Table)は、メモリセグメントを管理するためのデータ構造である。

このデータ構造はIDTのものと非常によく似通っている。

GDTはSegment Descriptorと呼ばれる複数のEntryを持つテーブルであり、GDTのアドレスをGDTRレジスタに設定する必要がある。

このTableのエントリは、Segment Selectorによってアクセスされ、該当するアドレス領域はどこかという情報や、その領域ではどの様な操作が許可されているかなどの情報を得ることができる。

Segument SelectorはSegumentation RegistersやIDTの各EntryのフォーマットであるGate Descriptor、Task State Segumentなどの中に現れるものである。

詳細については本稿では説明を省略しているため、気になった場合は調べてみてほしい

LDT(Local Descriptor Table)は、GDTと同様にメモリにアクセスするためのセグメントを管理するデータ構造であるが、タスクやスレッド毎にLDTを保有できるという点で違いがある。

タスク毎にGDTに相当するディスクリプタを持たせることは、自身のプログラム、タスク間ではセグメントを共有しつつ、異なるタスクとはセグメントを分離することができるため、タスク間のセキュリティを高めることに寄与する。

LDTも今回の実装では関わってこない話なので、この詳細についてもここでは省略する。

GDT setup for 64-bit mode

64-bit Boot Protocolにも記載がある通り、64-bit modeの場合はそれぞれのSegment descriptorは4G flat segmentとしてセットアップする必要があり、Code Segument、Data Segumentはそれぞれ適切な権限を付与する必要がある。

その一方Gloabl Descriptor Tableを確認すると、64-bit modeの場合は基本的にbase, limitが無視され、各Descriptorは全体のリニアアドレススペースをカバーするという記載があるため、Flag以外についてはどの様な値を書いていてもよさそうではある。今回は念の為、明示的にflat segumentとしてセットアップを行った。

また、DS、ES、SSの値はDSと同一にする必要がある旨についても記載があるため、これに習って実装する。

以降では、ToyVMM(Firecrackerと読み替えていただいても差し支えない)の実装を参考にこれらがどの様に設定されているかを確認してみる。

この設定はconfigure_seguments_and_sregs関数で実施されている。説明をしやすくするために、一部コメントを追記している

#![allow(unused)] fn main() { fn configure_segments_and_sregs(sregs: &mut kvm_sregs, mem: &GuestMemoryMmap) -> Result<(), RegError> { let gdt_table: [u64; BOOT_GDT_MAX as usize] = [ gdt::gdt_entry(0, 0, 0), // NULL gdt::gdt_entry(0xa09b, 0, 0xfffff), // CODE gdt::gdt_entry(0xc093, 0, 0xfffff), // DATA gdt::gdt_entry(0x808b, 0, 0xfffff), // TSS ]; // > https://wiki.osdev.org/Global_Descriptor_Table // // 55 52 47 40 39 31 16 15 0 // CODE: 0b0..._1010_1111_1001_1011_0000_0000_0000_0000_0000_0000_1111_1111_1111_1111 // <-f-> <-Access-><---------------------------> <----- limit -----> // - Flags : 1010 => G(limit is in 4KiB), L(Long mode) // - Access : 1001_1011 => P(must 1), S(code/data type), E(executable), RW(readable/writable), A(CPU access allowed) // - 0xa09b of A,9,B represents above values // // DATA: 0b0..._1100_1111_1001_0011_0000_0000_0000_0000_0000_0000_1111_1111_1111_1111 // - Flags : 1100 => G(limit is in 4KiB), DB(32-bit protected mode) // - Access : 1001_0011 => P(must 1), S(code/data type), RW(readable/writable), A(CPU access allowed) // // TSS // - Flags : 1000 => G(limit is in 4KiB) // - Access : 1000_1011 => P(must 1), E(executable), RW(readable/writable), A(CPU access allowed) // - TSS requires to support Intel VT let code_seg = gdt::kvm_segment_from_gdt(gdt_table[1], 1); let data_seg = gdt::kvm_segment_from_gdt(gdt_table[2], 2); let tss_seg = gdt::kvm_segment_from_gdt(gdt_table[3], 3); // Write seguments write_gdt_table(&gdt_table[..], mem)?; sregs.gdt.base = BOOT_GDT_OFFSET as u64; sregs.gdt.limit = mem::size_of_val(&gdt_table) as u16 - 1; write_idt_value(0, mem)?; sregs.idt.base = BOOT_IDT_OFFSET as u64; sregs.idt.limit = mem::size_of::<u64>() as u16 - 1; sregs.cs = code_seg; sregs.ds = data_seg; sregs.es = data_seg; sregs.fs = data_seg; sregs.gs = data_seg; sregs.ss = data_seg; sregs.tr = tss_seg; // 64-bit protected mode sregs.cr0 |= X86_CR0_PE; sregs.efer |= EFER_LME | EFER_LMA; Ok(()) } }

上記ではセットアップするGDTとして4 Entryを持つテーブルを作成している。

最初のEntryはGDTの要求としてNullでなければならないため、そのようなエントリを作成している。

それ以外は全体のメモリ領域に対して、CODE Segment、DATA Segment、TSS Segmentの設定を行なっていることが分かるだろう。

TSSの設定はIntel VTの要求を満たすために設定されており、本資料の範疇では実質使用しない内容である。

さて、このGDTを作成する際に各エントリを作成する関数gdt_entryを呼び出しているが、この内容を以下に転載する。

#![allow(unused)] fn main() { pub fn gdt_entry(flags: u16, base: u32, limit: u32) -> u64 { ((u64::from(base) & 0xff00_0000u64) << (56 - 24)) | ((u64::from(flags) & 0x0000_f0ffu64) << 40) | ((u64::from(limit) & 0x000f_0000u64) << (48 - 16)) | ((u64::from(base) & 0x00ff_ffffu64) << 16) | (u64::from(limit) & 0x0000_ffffu64) } }

この関数の引数として、全てのエントリがbaseに0x0、limitに0xFFFFF (2^5 = 32bit = 4GB)を指定しているためフラットなセグメンテーションになっている。第一引数であるflagsについてはEntry毎に設定を行なっており、これが翻ってGDTのFlagsやAccessByteの値に対応するようになる。

実際にそれぞれのEntryをgdt_entryに与えた結果返却される値と、その値を解析した内容が上記コード上のコメントになっている。

コメントを確認すると、64-bit Boot Protocolで要求されていた通り、CODE SegumentにはExecute / Read permissionと、さらにlong mode (64-bit code segment)のフラグが、DATA SegumentにはRead / Write permissionが付与されていることが分かる。

上記の通り作成したGDTを、write_gdt_table関数でGuestMemory上に書き込み、その先頭アドレスをsregs.gdt.baseに残している。

後続するIDTの設定だが、上述した通りここはdisabledとなるようだ。そのためか、特に何もメモリ上に書き込んでない。ただしGuestMemory上のどの位置を利用するかについては決めてあり、そのアドレスをsregs.idt.baseに残している。

引き続き、そのほかのレジスタ値を設定する。

上述した通りCSにはCODE segumentの情報を、DS, ES, SSにはData Segumentの情報を、TRにはTSS Segumentの情報を格納しておく。

上記のコードではFS, GSにもDATA Segumentの情報を書いているが、これらのセグメントの値はおそらく設定しなくても良い。

最後に、CR0やEFERレジスタの設定をしているがこの説明は後述する。

64-bit protected mode

Long modeとはx86_64プロセッサ用のネイティブモードであり、従来(x86)に比べていくつかの追加機能がサポートされているが、ここではこれらについて詳細には記載しない

Long modeはさらに64-bit modeと互換モードの2つのサブモードから構成される。

64-bitモードに切り替えるには、以下の処理が必要になる

- CR4.PAEを設定し、物理アドレス拡張機構を有効化する

- Page Tableの作成、CR3レジスタへトップレベルページテーブルのアドレスを読み込む

- CR0.PGを設定し、Pagingの有効化する

- EFER.LMEを設定し、Long Modeの有効化する

レジスタ値の設定はkvm_sregs構造体のうち対応するものを更新しset_sregsで設定するだけであり、既に説明済みであるため同様に実施すれば良い。

それ以外に重要な作業としてPage Tableの作成がある。

特に64-bit modeに移行するためには、4-Level Page Tableを構築する必要があるため、これに焦点をしぼって以降簡単にPagingについて説明をする。

4-Level Page Table for entering 64-bit mode

これまで特に言及をしてこなかったが、Linux Kernelの起動に関わる処理は、利用できるメモリアドレス空間の違いによって何段階かに名称分けされている。

起動直後、物理メモリアドレスを直接触ってセットアップを進める処理は、x16 Real-Modeと呼ばれ、その名の通り16bitのメモリアラインメントで処理が進んでいく。

一方、読者もよく知っている通り、我々の馴染みがあるOSは32bitであったり、64bitである。

これらはCPUのモード切り替えと呼ばれる機能により、x32 Protected Mode、x64 Long Modeと呼ばれるモードに切り替えられるが、これらのモードに切り替えられた途端、CPUは仮想メモリアドレスしか利用できない状態になる。

また、特にx64 CPUアーキテクチャでは基本的に4-level page tableによって、64bit 仮想アドレスが物理アドレスに変換されることが期待される.

つまり、x64 Long Modeに切り替える前に4-level page tableを構成してCPUに伝える必要があり、この処理はBootLoaderの機能の一部として実装される。

さてもう一つ重要な点としては、今RIPの値にはカーネルのエントリーポイントを示す物理アドレスの値が格納されているが、x64 Long Modeで取り扱う際にこのアドレスが仮想アドレスの値として利用されるため、別の物理アドレスに変換されてしまうとOSが起動できなくなってしまう。

したがって、ここではまず仮想メモリアドレスが同じ物理メモリアドレスにマッピングされる簡単なページテーブル(これは特にIdentity Mappingと呼ばれる)を作成すること上記の問題に対応する

Note

ここでBootLoaderが作成するPage Tableはx64でカーネルを実行するために一時的に必要な処理であることに注意されたい。

通常我々が仮想メモリアドレスやPage Tableと聞いた時に多くの場合に思い浮かべるのは、ユーザスペースのプロセスに対してのアドレスの話であるが、このユーザプロセスに対するPagingの仕組みはカーネル内部に実装があり、カーネルの起動とともに構成されるものであるため、今回の話とは切り離して考えるべきである。

つまり、このBootLoaderのpage tableの変換の仕組みがIdentity Mappingであろうがなかろうが、OS起動後の各プロセスに対するPagingの仕組みには影響がないということである。

Page Table implementation in ToyVMM

ここではToyVMMの実装を具体的に見ていきながら、Page Tableの構成について理解を深める。

この実装はFirecrackerの実装を模倣しているため、実質的にFirecrackerの実装と読み替えていただいて問題ない。

まずは、簡単に4-Level Page Tableの構造について議論しておく。基本的には以下の名称でLevel毎にTableが存在しそれぞれ名称分けされている。

- Level 4: Page Map Level 4 (PML4)

- Level 3: Page Directory Pointer Table (PDPT)

- Level 2: Page Directory Table (PDT)

- Level 1: Page Tables (PT)

また、各Tableはそれぞれ512個のEntityを格納可能であり、一つのEntityは8byte(64bit)からなるため、Table全体としては512(entity) * 8(byte/entity) = 4096(byte)となる。これは1つのPage(4KB)にちょうど収まるサイズになっている。

それぞれのLevelのEntiryは以下のような構造になっている

(引用元: x86 Initial Boot Sequence、OSdev/Paging。64bitのうちHigh bitについては今回あまり重要ではないので紙面の都合上省略している)

上記から、以下の内容を満たしながらセットアップすればよさそうである。

- CR3のなかで、PML4のアドレスとして利用されるデータは12~32+bitになるため、これを考慮してPML4のアドレスを設計する

- PML4は有効化のために0bit目は1にセットし、12~32+bitにPDPTのアドレスを設計する

- PDPTE page directoryのレイアウトを利用するために、PDPTEの7bit目は立てず、12~32+bitのレンジにPDのアドレスを設計する

- PDEでは2MB pageを許可するため7bit目を立て、21~32+bitのレンジにPhysical Addressを設計する

- Firecrackerでは、Level1 Page Tableを利用せず(= 4KiB pageを利用せず)、2MiB Pagingで実装しているようである。ToyVMMの実装もこれに倣う(2MiBページングは基本的に多くのCPUでサポートされている上、4KiBページングによるPage Tableの肥大化を伏せるためかと思われる)

さて、上記をもとに実際の実装部分のコードを抜粋する

#![allow(unused)] fn main() { fn setup_page_tables(sregs: &mut kvm_sregs, mem: &GuestMemoryMmap) -> Result<(), RegError> { let boot_pml4_addr = GuestAddress(PML4_START); let boot_pdpte_addr = GuestAddress(PDPTE_START); let boot_pde_addr = GuestAddress(PDE_START); // Entry converting VA [0..512GB) mem.write_obj(boot_pdpte_addr.raw_value() as u64 | 0x03, boot_pml4_addr) .map_err(|_| RegError::WritePdpteAddress)?; // Entry covering VA [0..1GB) mem.write_obj(boot_pde_addr.raw_value() as u64 | 0x03, boot_pdpte_addr) .map_err(|_| RegError::WritePdpteAddress)?; // 512 MB entries together covering VA [0..1GB). // Note we are assuming CPU support 2MB pages (/proc/cpuinfo has 'pse'). for i in 0..512 { mem.write_obj((i << 21) + 0x83u64, boot_pde_addr.unchecked_add(i * 8)) .map_err(|_| RegError::WritePdeAddress)?; } sregs.cr3 = boot_pml4_addr.raw_value() as u64; sregs.cr4 |= X86_CR4_PAE; sregs.cr0 |= X86_CR0_PG; Ok(()) } }

見た通り実装はかなりシンプルである。

PML4_START、PDPTE_START、PDE_STARTにはそれぞれアドレス値がハードコードされており、それぞれPML4_START=0x9000、PDPTE_START=0xa000、PDE_START=0xb000となっていて、これは上記したそれぞれのアドレス設計の要求を満たしている。

上記を見ると分かる通り、PML4及びPDPT Table自体は1つずつであり、Entryとしても最初のものしかセットアップしていない。これはこのページテーブルで変換されるカーネルのアドレスが、0x0100_0000であり、これを仮想アドレスとして扱った場合、詳しくは後述するが、PML4、PDPTは必ず最初のEntryを見ることになるためこの実装で十分である。

PML4には、PDPTの先頭アドレス情報に0x03の論理和を取ったものを書き込み、PDPTにも同様にPDの先頭アドレス情報に0x03の論理和を取ったものを書き込む。

ここで0x03で論理和を取っている理由は、PML4E、PDPTEの0, 1bit目のフラグを立てるためであり、1bit目は共にR/W許可に関するフラグ、0bitは共に当該Entryの存在性に関してのフラグに該当するため今回のケースでは必須の処理である。

PDは512 Entry分作成するためにループし、ループのindexの値を21bit shiftさせたものと0x83の論理和を取ったものを、PDの先頭アドレスから8byte毎(=1 Entry size毎)に書き込んでいる。

ここで0x83で論理和を取っている理由は、前述しているR/W許可フラグ、存在性確認のフラグに加えて、2MBのpage frameとして扱うかどうかに関わるフラグを立てるためである。このフラグを立てることによって、21bit目からの値をアドレスとして取り扱う(図の「PDE 2MB page」のレイアウトを利用することになる)。したがって、上述したループで格納したindex値を21bitオフセット(2^21 = 2MB)させた値がそのまま変換後の物理アドレス値に対応するとになるため、PDEとしてはindex=0のEntryは0を21bit offsetした値(= 0x0000_0000)、index=1のEntryは1を21bit offsetした値(= 0x0010_0000)というように変換されることになる。

さて、以降では上記で作成したPage Tableで、EIPに格納したkernelのアドレス(0x0100_0000)は正しく変換されるのか実際に計算して確かめてみよう!

前述した通り、x64 Long Modeへ移行すると、このカーネルのアドレスは64bit仮想アドレスとして取り扱われることになる。今、ToyVMM(およびFirecracker)ではカーネルを物理アドレスの0x0100_0000に読み込んでおり、その値がeipレジスタに格納されている。

したがって、0x0100_0000を仮想アドレスとして扱い、上述した変換テーブルを用いてアドレス変換を行った結果、0x0100_0000になることを期待したい。

では具体的に計算してみよう。64bit仮想アドレスを4-Level Page Tableで変換する場合は以下の図の様に仮想アドレスの下位48bitを9 + 9 + 9 + 9 + 12bit毎に分割し、4つの9bitを先頭からそれぞれ各Page tableのEntryのindex値として利用する。この方法で特定したEntryのレイアウトを確認して、次のPage Tableの物理アドレスを確認し、同様にその物理アドレスと仮想アドレスから得たEntryのindex値を元に次のPage Tableの対象のEntryを割り出す。これを続けると最終的に目的の物理アドレスを得ることができる。Pageは少なくとも4KB毎のサイズになっているため、アドレス値としても4KB毎の値になるため、仮想アドレスの最後の12bitはそのオフセット(2^12 = 4KB)として利用される。

今回はPDEで2MB page frameとして取り扱うフラグを立てていることを思い出してほしい。この場合はPDEから得られる結果をそのまま物理アドレスへのマッピングとして利用する。この時使われないPTEの9bit分はオフセットとして取り扱われ、元々の12bitと合わせて合計21bit分のoffsetを加えることになる。この21bitオフセットが2MBに対応していることになる。同様にPDPTEでフラグを立てていると1GB page frameとして扱われるという仕組みになっている。

上記の話をもとに、0x0100_0000を変換してみる。この値はわかりやすさのためにbitで表現すると0b0..._0000_0001_0000_0000_0000_0000_0000_0000である。これを仮想アドレス変換の方式に倣いbitを分解すると、以下の通りになる。

| Entry index for | Range of Virtual Address | Value |

|---|---|---|

| Page Map Level4 (PML4) | 47 ~ 39 bit | 0b0_0000_0000 |

| Page Directory Pointer Table (PTPT) | 38 ~ 30 bit | 0b0_0000_0000 |

| Page Directory Table (PDT) | 29 ~ 21 bit | 0b0_0000_1000 |

| Page Tables (PT) | 20 ~ 12 bit | 0b0_0000_0000 |

| - | 11 ~ 0 bit (offset) | 0b0_0000_0000 |

これを見ると分かる通り、PML4E、PDPTE用のindex値は0になるため、それぞれのTableの先頭アドレスから64bit確認することになる。

実装で確認した通り、index=0のPML4EにはPDPTのアドレスが書かれており、index=0のPDPTEにはPDTのアドレスが書かれているため、PDTまでは順当に辿り着く。

さて、今回PDEのIndex値は上記の仮想メモリアドレスから0b0_0000_1000なのでPDTの中で8番目のEntryを確認することになるが、当該Entryの2MB Page frameの領域に書かれている値は実装から0b0...0000_1000であることが分かる。

したがって、この値に21bit offsetを加えた値である0b1_0000_0000_0000_0000_0000_0000 = 0x100_0000が変換により得られる物理アドレスであり、これは入力した仮想アドレスと一致している。

したがって、変換後もカーネルのエントリーポイントを指すことになり、64-bit long modeにシフトしてもカーネルを起動から処理が開始されることになる

Note

今回作成したPage Tableを再考してみると、PML4、PDPT用のEntryは1つしか作っていないので、そもそも対象となる仮想メモリアドレス範囲はMaxでも2^31 - 1までの範囲になる(この領域を超える場合、PML4E、PDPTEとしてindexが0以外を指す場合が存在してしまう)

加えて、PDのEntryでは2MB page frameを有効化しているため、仮想メモリアドレスの下位21bitはOffsetとして取り扱われる。

その上で、PDEのアドレス設計をindexに対応付けているため、このPage Tableは 2^21 ~ 2^30-1の範囲でIdentity Mapping になっている。

What to do next?

実はここまでの話を組み合わせるだけで、Guest VMを起動すること自体は可能である。

しかし、この状態ではGuest VMは起動できてもそれを操作することはできないという何とも片手落ちな状態になってしまう。

起動したGuest VMが我々の想定した通りの設定になっているかなどを確認するためにも、Guest VMを操作するようなインターフェイスを作りたいところである。

次の章ではこれを達成するためにSerialについて議論し、ToyVMMの中に実装することでGuest VMを起動後にキーボード操作できるようにする!

References

- The Linux/x86 Boot Protocol - 64-bit Boot Protocol

- Linux Insides: カーネル起動プロセス part4

- Global Descriptor Table (wiki)

- Interrupt Descriptor Tabke (wiki)

- Segmentation (wiki)

- Control register (wiki)

- Long mode (wiki)

- x86 initial boot sequence

- Virtual Memory - Intro to Paging Tables

- Writing an OS in Rust - Introduction to Paging

- Intel 64 and IA-32 Architectures Software Developer's Manual

Serial Console implementation

About Serial UART and ttyS0

UART(Universal Asynchronous Receiver/Transmitter)はコンピュータやマイコンと周辺機器を繋ぐ非同期式シリアル通信規格である。 UARTによってシリアル・パラレル信号の相互変換を行えるため、入力されるパラレルデータをシリアルデータへ変換し通信回線越しに相手に送信することができる。 これを実装するために設計された集積回路として8250 UARTと呼ばれるデバイスが製造され、その後さまざまなファミリが登場してきた。

さて、今回Guest OS(Linux)を起動させようとしているわけであるが、デバッグ等の用途としてシリアルコンソールが存在すると便利なケースが多い。

シリアルコンソールはGuestの全てのコンソール出力をシリアルポートに送付するため、シリアルターミナルが適切に設定されていればリモートターミナルとしてシステムの起動状況を確認したり、シリアルポート経由でシステムにログオンしたりすることができる。

今回は、ToyVMM上で起動したGuest VMの状態確認やGuestの操作をするためにこの方式を利用することにする。

コンソールメッセージをシリアルポートに出力させるために、カーネルの起動時パラメータとしてconsole=ttyS0を設定する必要がある。

現在のToyVMMの実装ではこの値をデフォルト値として与えている。

問題はこれを受け取るシリアルターミナル側である。

シリアルポートに該当するIO Portのアドレスは決まっているため、ToyVMMのレイヤからは当該アドレス付近に対してKVM_EXIT_IOの命令を受けることになる。

つまりGuest OS側から発行されるシリアルコンソールへの出力情報、またそれ以外にも必要なセットアップ要求などを適切に処理する必要があり、これはUARTデバイスをエミュレートすることで成立させる必要がある。

その上で、デバイスをエミュレートした結果として、標準出力に対してコンソール出力を出力したり、逆に我々の標準入力をGuest VM側に反映させることができれば、ToyVMMからVMを起動した際に、その起動情報の確認やGuestの操作を手元のターミナルから実施することが可能になる。

以上をまとめると、大まかに下記のような概念図のものを作成することになる。

以降では順を追って説明していく。

Serial UART

Serial UARTについては、以下のLammet Biesの資料とWikibooksに大変詳細な情報が記載されているため基本的にはこれを確認すれば良い。

以下の図は、Lammetの資料に記載のある図を引用しつつそれぞれのRegisterの各bitに関して簡単に説明を加えた図である。本資料の執筆において個人的に作成した図であるが、読者の理解の手助けになることを期待して添付しておく。 ただし、それぞれのregisterやbitの意味については本資料では説明はしないため、上記の資料を参考に確認してもらいたい。

基本的には上記のregisters/bitsを操作することで必要な処理を行うのがUARTの仕組みになっている。

今回はこれをSoftwareでエミュレートする必要があるが、この実装に関しては rust-vmm/vm-superioを利用することで代替とする。

以降でこの rust-vmm/vm-superio の実装と上記のSpecificationとを比較しながら簡単にではあるが確認していこうと思う。

rust-vmm/vm-superioによるSerial DeviceのSoftware実装

初期値設定/RWの実装

ここからはrust-vmm/vm-superioを利用したserial deviceの実装を、上記のSpecificationと比較しながら確認していく。

是非、上記からコードを取得して自分で確認してみてほしい。

なお、以下の内容は vm-superio-0.6.0 に準拠しているので、最新のコードでは変更されているかもしれないため留意されたい。

まず、いくつかの値の初期値について以下の通りに整理する。

rust-vmm/vm-superioはもともとVMMでの利用を前提にしているため、いくつかのレジスタの値を初期設定していたり、書き換え想定をしていなかったりする。

| Variable | DEFAULT VALUE | Meaning | REGISTER |

|---|---|---|---|

| baud_divisor_low | 0x0c | baud rate 9600 bps | |

| baud_divisor_high | 0x00 | baud rate 9600 bps | |

| interrupt_enable | 0x00 | No interrupts enabled | IER |

| interrupt_identification | 0b0000_0001 | No pending interrupt | IIR |

| line_control | 0b0000_0011 | 8 bit word length | LCR |

| line_status | 0b0110_0000 | (1) | LSR |

| modem_control | 0b0000_1000 | (2) | MCR |

| modem_status | 0b1011_0000 | (3) | MSR |

| scratch | 0b0000_0000 | SCR | |

| in_buffer | Vec::new() | vector values (buffer) | - |

- THR empty関係のbitを立てている。このbitを立てているといつでもデータを受信可能であることを表現していることになるが、これは仮想デバイスとしての利用が前提の設定になっている。

- 多くのUARTはAuxiliary Output 2の値を1に設定し、interruptを有効にするたデフォルトで有効にしている

- Connectedの状態、かつハードウェアデータフローの初期化

さて、次にwriteのリクエストが来た場合の処理内容について簡単に記載する。

KVM_EXIT_IOの結果として、IOが発生したaddressと、書き込むべきデータが渡される。

ToyVMM側ではこれらの値から適切なデバイス(今回はSerial UART device)とそのベースアドレスからのOffsetを計算し、vm-superioで定義されているwrite関数を呼び出す。

以下の内容は、Serial::writeの処理を簡単に表に起こしたものである。基本的には素直にレジスタ値の書き換えになるが一部ちょっとロジックが入る。

| Variable | OFFSET(u8) | Additional Conditions | write |

|---|---|---|---|

| DLAB_LOW_OFFSET | 0 | is_dlab_set = true | self.baud_divisor_lowを書き換え |

| DLAB_HIGH_OFFSET | 1 | is_dlab_set = true | self.baud_divisor_highを書き換え |

| DATA_OFFSET | 0 | - (is_dlab_set = false) | (1) |

| IER_OFFSET | 1 | - (is_dlab_set = false) | (2) |

| LCR_OFFSET | 3 | - | self.line_controlを書き換え |

| MCR_OFFSET | 4 | - | self.modem_controlを書き換え |

| SCR_OFFSET | 7 | - | self.scratchを書き換え |

- 現在のSerialの状態として、LOOP_BACK_MODE(MCR bit 4)が有効になっている場合とそうでない場合で場合分け

- 有効の場合、送信レジスタに書かれたものをそのまま受信レジスタに書き込まれる(loopbackする)ようにシミュレート(今回は重要ではない)

- 有効でない場合、書き込むべきデータをそのまま出力に書き出し、既存の設定状態に依存して割り込みを入れる。

- 上記の表をみてわかる通り、外部からのwriteによるIIRの変更はサポートしておらず、デフォルト値が

0b0000_0001で設定されている。 - もし、IER_OFFSETに対してIERのTHR empty bitのフラグが立っている場合は、IIRのTHR emptyに対応するフラグを立てて割り込みをトリガする。

- 上記の表をみてわかる通り、外部からのwriteによるIIRの変更はサポートしておらず、デフォルト値が

- IERのbitのうち0-3bit以外はMaskした結果(Interruptに関連するbitのみそのままにして)で

self.interrupt_enableを書き換え

次に、readのリクエストが来た場合の処理内容について簡単に記載する

同様に Serial::readの処理を表に起こしたものが下記である。readの場合はwriteと異なり基本的には返り値としてデータを返すロジックになっている

| Variable | OFFSET(u8) | Additional Conditions | write |

|---|---|---|---|

| DLAB_LOW_OFFSET | 0 | is_dlab_set = true | self.baud_divisor_lowを読み込み |

| DLAB_HIGH_OFFSET | 1 | is_dlab_set = true | self.baud_divisor_highを読み込み |

| DATA_OFFSET | 0 | - (is_dlab_set = false) | (1) |

| IER_OFFSET | 1 | - (is_dlab_set = false) | self.inerrupt_enableを読み込み |

| IIR_OFFSET | 2 | - | (2) |

| LCR_OFFSET | 3 | - | self.line_controlを読み込み |

| MCR_OFFSET | 4 | - | self.modem_controlを読み込み |

| LSR_OFFSET | 5 | - | self.line_statusを読み込み |

| MSR_OFFSET | 6 | - | (3) |

| SCR_OFFSET | 7 | - | self.scratchを読み込み |

- Serial構造体が持つbufferのデータを読み出したりするが、現実装ではこのbufferはloopback modeでのwriteでしかデータが積まれない実装になっているため、今回の内容では省略。OSの起動シーケンスでもこの領域に関する

readは発行されていなかった。 self.interrupt_identification|0b1100_0000(FIFO enabled)の結果を返却しデフォルト値に戻す- 現在の状態がloopback modeかどうかで場合分けを行う

- loopbackの場合は適切に調整する(今回は重要ではないので省略)

- loopbackで無い場合は素直に

self.modem_statusの値を返却する

ToyVMMでのrust-vmm/vm-superioの利用

ToyVMMでは上記のrust-vmm/vm-superioを利用しKVM_EXIT_IOの内容をハンドルする。

加えて考えなければならないのは以下の2点である。

- Guestからシリアルポートに当てたコンソール出力を標準出力に書き出すことで、起動シーケンスやGuest内部の状態を確認できるようにする。

- 標準入力の内容をGuest VMに引き渡す

以降、それぞれ順番に確認していく。

シリアルポート当てのコンソール出力を標準出力に書き出す

起動シーケンスやGuest VMの内部状態を確認するために、シリアルポート宛のコンソール出力を標準出力に書き出すようにしてみよう。

「シリアルポート当てのコンソール出力」はまさに、KVM_EXIT_IOでSerial向けのIO Portアドレスに対してのKVM_EXIT_IO_OUTのケースに該当する。

以下のコード部が該当処理になる。

#![allow(unused)] fn main() { ... loop { match vcpu.run() { Ok(run) => match run { ... VcpuExit::IoOut(addr, data) => { io_bus.write(addr as u64, data); } ... } } } ... }

さて、ここではKVM_EXIT_IO_OUTで受け取ったアドレスと書き込むべきデータを伴って、io_bus.writeを呼び出すのみになっている。

このio_busは以下のような形で設定を行ったものである。

#![allow(unused)] fn main() { let mut io_bus = IoBus::new(); let com_evt_1_3 = EventFdTrigger::new(EventFd::new(libc::EFD_NONBLOCK).unwrap()); let stdio_serial = Arc::new(Mutex::new(SerialDevice { serial: serial::Serial::with_events( com_evt_1_3.try_clone().unwrap(), SerialEventsWrapper { buffer_read_event_fd: None, }, Box::new(std::io::stdout()), ), })); io_bus.insert(stdio_serial.clone(), 0x3f8, 0x8).unwrap(); vm.fd().register_irqfd(&com_evt_1_3, 4).unwrap(); }

上記のセットアップについては少し説明が必要なため以降に順を追って話していくが、大まかに押さえておくと以下のようなことをおこなっている。

- I/O Busを表現している

IoBus構造体、割り込みを表現するeventfdを初期化する。 - Serial Deviceの初期化をおこなう。その際にGuestへ割り込みを発生させるための

eventfdと標準出力のためのFD(std::io::stdout)を渡している。 - 初期化した

IoBusに上記のSerial Deviceを登録している。この時、0x3f8をベースアドレス、0x8をレンジとして登録している。- これにより、

0x3f8を基底として0x8のレンジはこのSerial Deviceが利用するアドレス領域ということを表現している。

- これにより、

I/O Busの取り回し

KVM_EXIT_IOで渡されるアドレス値は、アドレス空間全体におけるアドレスの値になる。

一方で、rust-vmm/vm-superioのread/writeの実装は、Serial Deviceのベースアドレスからのオフセット値をとって処理を実施するような実装になっているため、このギャップを埋めるための処理が必要になる。

単純にオフセットを計算するだけでも良いが、Firecrackerではその後の拡張性(Serialデバイス以外のIO Portを利用するデバイス)も考慮してか、I/O Busを表現する構造体であるBusという構造体が存在する。

これはBusRange(バスにおけるデバイスのベースアドレスと利用するアドレスレンジを表現している構造体)とともにデバイスを登録できるようなものになっている。

さらに、あるアドレスへのIOが発生しときに、そのアドレスを確認し、対応するアドレスレンジに登録されているデバイスを取り出して、そのデバイスに対して、ベースアドレスからのオフセット値でIOを実行するような仕組みが提供されている。

例えばwrite関数は以下のような実装になっており、get_deviceでアドレス情報から対応する登録済みデバイスと、そのデバイスのベースアドレスからのオフセットを取得し、それを利用してデバイスに実装されているwrite関数を呼び出している。

#![allow(unused)] fn main() { pub fn write(&self, addr: u64, data: &[u8]) -> bool { if let Some((offset, dev)) = self.get_device(addr) { : u64 : &Mutex<dyn BusDevice> // OK to unwrap as lock() failing is a serious error condition and should panic. dev.lock() Result<MutexGuard<dyn BusDevice>, …> .expect("Failed to acquire device lock") MutexGuard<dyn BusDevice> msg: .write(offset, data); true } else { false } } }

具体的にSerialデバイスの話を例に挙げて考えてみる。

前述した通りGuest VMからのserialに対するKVM_EXIT_IO_OUTは0x3f8をベースとして8 byteのアドレスレンジで発生する。

ToyVMMのIoBusでも同様のアドレスベース、レンジ情報でSerial Deviceの登録をしているため、例えばKVM_EXIT_IO_OUTとして0x3fbへ0b1001_0011を書き込むという命令をトラップした場合、登録したSerial Deviceに対して、ベースアドレス(0x3f8)からのオフセット(0x3)の位置、つまりLCRに0b1001_0011を書く、という命令に解釈される。

eventfd/irqfdによるGuest VMへの割り込み通知

ここからは少しKVMと割り込みに関する話をしたい。

いくつかLinuxのソースコードを引用することになるが以降ではv4.18のコードから引用する。

:warning: 以降の話は基本的にソースコードを元に記載しているが、詳細な状態遷移を逐一確認して記載したものではないため多少間違っている可能性があります。もし間違いを発見した場合はコメントをいただけると幸いです。

rust-vmm/vm-superioでは、Serialの初期化時に第一引数にEventFdを要求する。

これはLinuxにおけるeventfdのWrapperになっているものである。

eventfdの詳細はmanを確認してほしいが、簡単にいうとプロセス間やプロセスとカーネルの間などでのイベントの通知を実現することができる仕組みである。

次にirqfdである。irqfdはeventfdをベースとしたVMに対して割り込みを入れることのできる仕組みである。

イメージとしてはeventfdの一端をKVMが保持し、もう片方からの通知をGuest VMへの割り込みとして解釈するというものである。

このirqfdによる割り込みは、Guest VMの外の世界からGuest VMへの割り込み、つまり通常のシステムで言うところの周辺デバイスからの割り込みをエミュレートするものである。逆方向の割り込みはioeventfdの仕組みを利用するがここでは一旦省略する。

実際にソースコードを見ながら、このirqfdがどのようにGuestへの割り込みにつながっていくかを確認してみよう。

KVMに対してKVM_IRQFDを伴ってioctlを実施すると、渡されたデータを元にkvm_irqfd、kvm_irqfd_assignの流れでKVMの処理が実行され、このkvm_irqfd_assign関数でkvm_kernel_irqfd構造体のインスタンスが作成される。

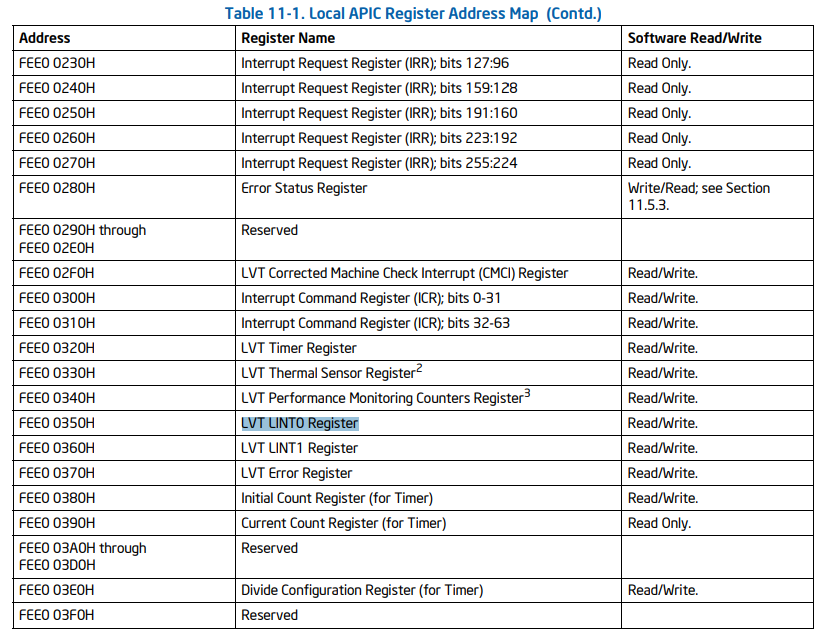

この時、ioctl時に渡した追加情報を元に設定を行うが、特にkvm_kernel_irqfd構造体はgsiというフィールドを持っており、これがioctlで渡した引数の値によって設定される。

このgsiは、irqfdに対応するGuestの割り込みテーブルのインデックスに該当するものになるため、ioctlを呼ぶ際にはeventfdに加えて、Guestのどの割り込みテーブルのエントリに対して割り込みを入れるかということも指定する。

ToyVMMではこの設定を行なっているのが以下の一行である。

#![allow(unused)] fn main() { vm.fd().register_irqfd(&com_evt_1_3, 4).unwrap(); }

これはkvm_ioctl::VmFd構造体のメソッドとして定義されている

#![allow(unused)] fn main() { pub fn register_irqfd(&self, fd: &EventFd, gsi: u32) -> Result<()> { let irqfd = kvm_irqfd { fd: fd.as_raw_fd() as u32, gsi, ..Default::default() }; // Safe because we know that our file is a VM fd, we know the kernel will only read the // correct amount of memory from our pointer, and we verify the return result. let ret = unsafe { ioctl_with_ref(self, KVM_IRQFD(), &irqfd) }; : i32 fd: req: arg: if ret == 0 { Ok(()) } else { Err(errno::Error::last()) } } }

つまり上記では、これまで話してきたSerial deviceに利用しているeventfd(com_evt_1_3)をGSI=4(Guest VM上のCOM1ポートへの割り込みテーブルインデックス)を伴って設定しているため、このcom_evt_1_3に対して実行したwriteは、COM1からの割り込みとしてGuest VMに渡り(つまり、Guestから見るとCOM1の先のserial deviceから割り込みが発生したことになり)、Guest VMのCOM1の割り込みハンドラを起動することになる。

さて、今Guest側の割り込みテーブル(GSI: Global System Interrupt)の話が出たが、これらはいつ、どのようにセットアップされるかいついて以降で説明していくこととする。

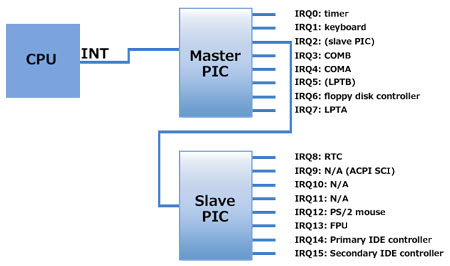

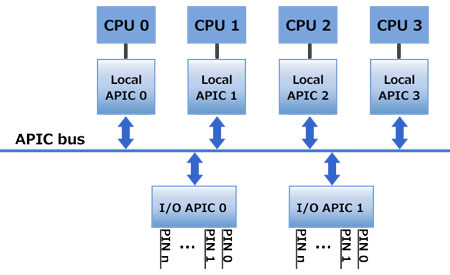

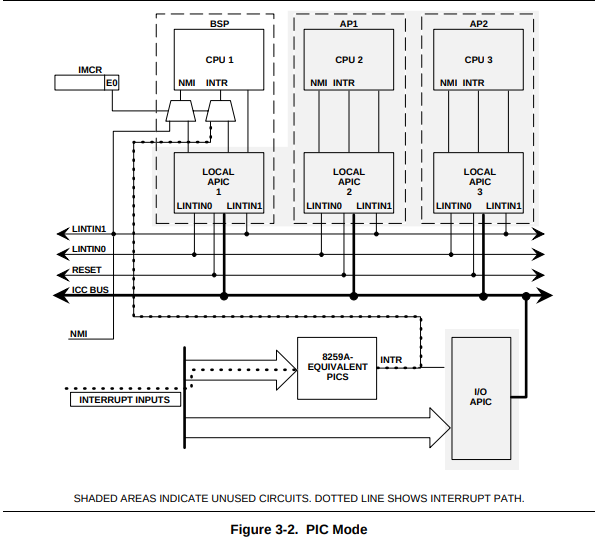

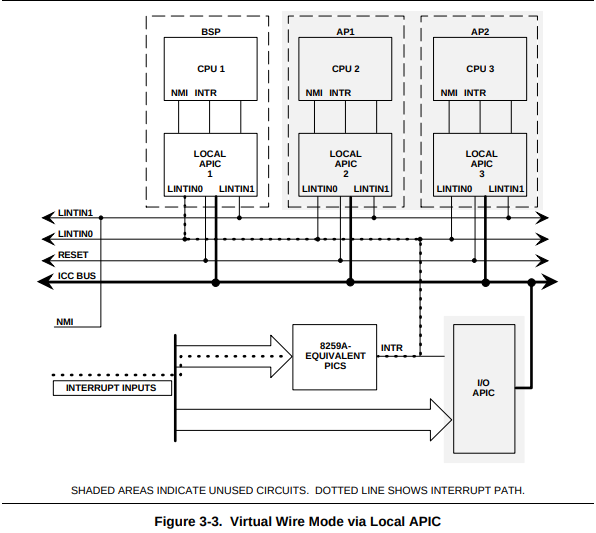

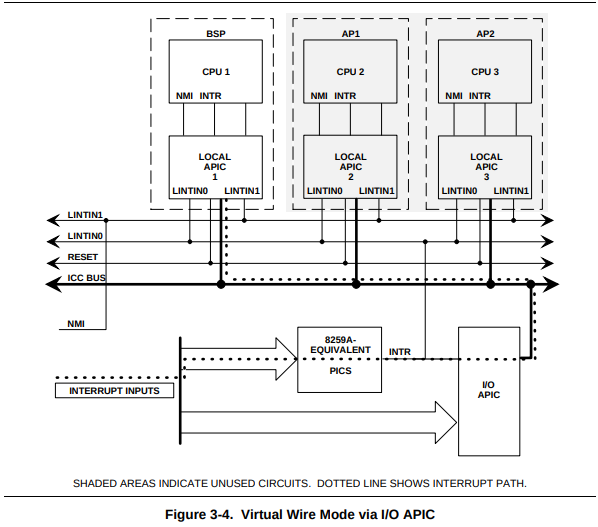

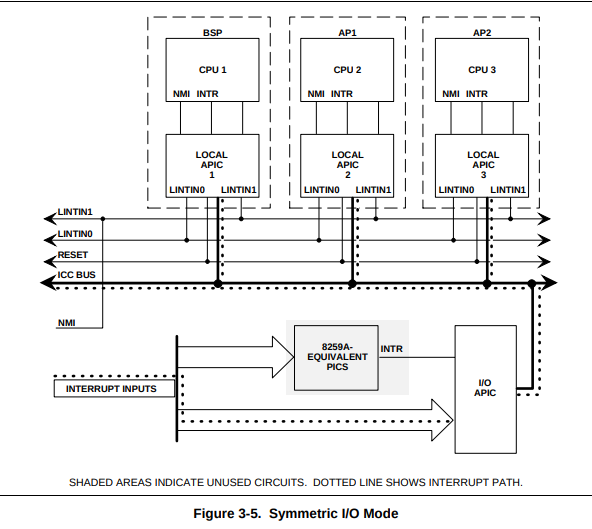

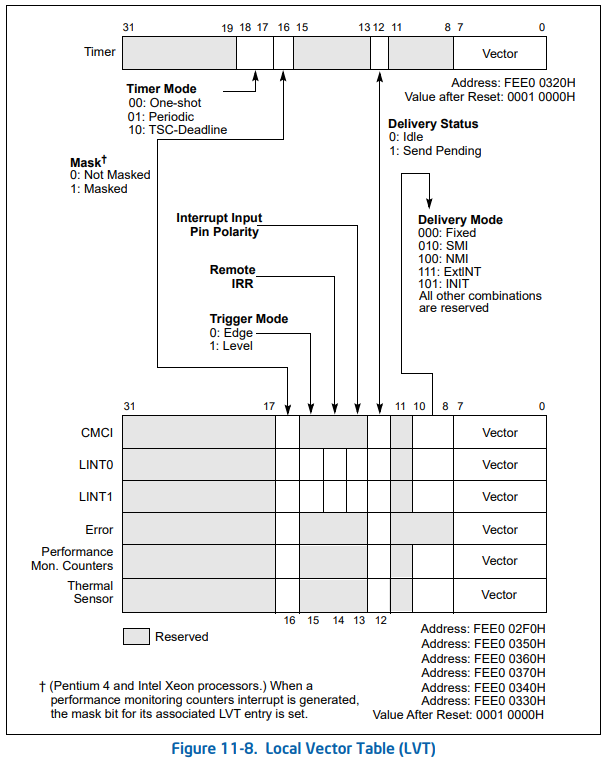

端的に言えばこれらはKVM_CREATE_IRQCHIPを伴ってKVMにioctlを発行することで設定される。これを実施すると割り込みコントローラであるPICとIOAPICの2種類が作成される(内部的にはkvm_pic_initでPICの初期化とread/write opsの登録などを行い、kvm->arch.vpicに設定。kvm_ioapic_initでIOAPICの初期化とread/write opsの登録などを行い、kvm->arch.vioapicに設定している)

このPICやIOAPICなどのハードウェアは高速化の目的でKVMに実装があるため、独自にエミュレートする必要がない。もちろんqemuなどに任せることができるが、ここでは利用しないため省略する。

さらにその後、kvm_setup_default_irq_routing関数の中でデフォルトのIRQ Routingの設定がなされている。

この処理によって、どのGSIに対する割り込みによってどのハンドラが起動するか、という部分がセットアップされる。

さて、もう少しkvm_setup_default_irq_routingの中身を見てみよう。この関数の中ではさらにkvm_set_irq_routing関数を呼びだしており、本質的な処理はそこに記載がある。

ここではkvm_irq_routing_tableを作成し、これに対してGSIからIRQへの対応を表現しているkvm_kernel_irq_routing_entryを設定していく形になる。

このkvm_kernel_irq_routing_entryはデフォルトのエントリ(default_routing)が存在しており、これをループしながら登録していくような形の実装が存在する。

このdefault_routingは以下のような定義になっている。関係するマクロの実装も記しておく。

#define SELECT_PIC(irq) \

((irq) < 8 ? KVM_IRQCHIP_PIC_MASTER : KVM_IRQCHIP_PIC_SLAVE)

#define IOAPIC_ROUTING_ENTRY(irq) \

{ .gsi = irq, .type = KVM_IRQ_ROUTING_IRQCHIP, \

.u.irqchip = { .irqchip = KVM_IRQCHIP_IOAPIC, .pin = (irq) } }

#define ROUTING_ENTRY1(irq) IOAPIC_ROUTING_ENTRY(irq)

#define PIC_ROUTING_ENTRY(irq) \

{ .gsi = irq, .type = KVM_IRQ_ROUTING_IRQCHIP, \

.u.irqchip = { .irqchip = SELECT_PIC(irq), .pin = (irq) % 8 } }

#define ROUTING_ENTRY2(irq) \

IOAPIC_ROUTING_ENTRY(irq), PIC_ROUTING_ENTRY(irq)

static const struct kvm_irq_routing_entry default_routing[] = {

ROUTING_ENTRY2(0), ROUTING_ENTRY2(1),

ROUTING_ENTRY2(2), ROUTING_ENTRY2(3),

ROUTING_ENTRY2(4), ROUTING_ENTRY2(5),

ROUTING_ENTRY2(6), ROUTING_ENTRY2(7),

ROUTING_ENTRY2(8), ROUTING_ENTRY2(9),

ROUTING_ENTRY2(10), ROUTING_ENTRY2(11),

ROUTING_ENTRY2(12), ROUTING_ENTRY2(13),

ROUTING_ENTRY2(14), ROUTING_ENTRY2(15),

ROUTING_ENTRY1(16), ROUTING_ENTRY1(17),

ROUTING_ENTRY1(18), ROUTING_ENTRY1(19),

ROUTING_ENTRY1(20), ROUTING_ENTRY1(21),

ROUTING_ENTRY1(22), ROUTING_ENTRY1(23),

};

見ての通り、0-15までのIRQ番号はROUTING_ENTRY2に、16-23までのをIRQ番号はROUTING_ENTRY1に引き渡しており、ROUTING_ENTRY2はIOAPIC_ROUTING_ENTRYとPIC_ROUTING_ENTRYを、ROUTING_ENTRY1はIOAPIC_ROUTING_ENTRYのみを呼び出して、必要な情報を埋めた構造体を作っている。

この構造体の情報を使いながら後続するkvm_set_routing_entry関数で以下の通りそれぞれの.u.irqchip.irqchipの値(KVM_IRQCHIP_PIC_SLAVE、KVM_IRQCHIP_PIC_MASTER、KVM_IRQCHIP_IOAPIC)ごとにコールバック(kvm_set_pic_irq、kvm_set_ioapic_irq)や必要な設定をおこなっている。このコールバックは割り込み発生時に呼ばれる関数に該当し、後ほど触れるため少し覚えておいてほしい。

int kvm_set_routing_entry(struct kvm *kvm,

struct kvm_kernel_irq_routing_entry *e,

const struct kvm_irq_routing_entry *ue)

{

/* We can't check irqchip_in_kernel() here as some callers are

* currently inititalizing the irqchip. Other callers should therefore

* check kvm_arch_can_set_irq_routing() before calling this function.

*/

switch (ue->type) {

case KVM_IRQ_ROUTING_IRQCHIP:

if (irqchip_split(kvm))

return -EINVAL;

e->irqchip.pin = ue->u.irqchip.pin;

switch (ue->u.irqchip.irqchip) {

case KVM_IRQCHIP_PIC_SLAVE:

e->irqchip.pin += PIC_NUM_PINS / 2;

/* fall through */

case KVM_IRQCHIP_PIC_MASTER:

if (ue->u.irqchip.pin >= PIC_NUM_PINS / 2)

return -EINVAL;

e->set = kvm_set_pic_irq;

break;

case KVM_IRQCHIP_IOAPIC:

if (ue->u.irqchip.pin >= KVM_IOAPIC_NUM_PINS)

return -EINVAL;

e->set = kvm_set_ioapic_irq;

break;

default:

return -EINVAL;

}

e->irqchip.irqchip = ue->u.irqchip.irqchip;

break;

...

さて、ここまで見てきたところで再度irqfdの話に立ち戻ろう。

先ほどは説明していなかったが、実はkvm_irqfd_assign関数の中では、init_waitqueue_func_entry(&irqfd->wait, irqfd_wakeup)という処理が呼び出され、&irqfd->wait->funcにirqfd_wakeupを登録している。

割り込みが発生した際にこの関数が呼び出され、この中でschedule_work(&irqfd->inject)が呼ばれる。

このinjectフィールドもkvm_irqfd_assign関数の中で初期化されており、結果としてirqfd_inject関数が呼び出されることになり、さらにこの関数の中でkvm_set_irq関数が呼び出される。

kvm_set_irqの処理の中では、割り込みがきたIRQ番号を持つエントリをリストアップし、そのsetコールバックを呼び出していく。これはつまり上記で説明したkvm_set_pic_irqやkvm_set_ioapic_irqなどの関数が呼ばれることを意味する。

以上の流れが割り込みとGSI、IRQ間Routingの実際の処理の部分である。

ここからの話は割り込み処理に対してもう少し深掘りした内容になるが、ToyVMMを理解する上で必ずしも必要ではない内容なので、ToyVMM serial consoleまで読み飛ばしてもらっても構わない。

折角なので、割り込みハンドラであるkvm_set_pic_irqの処理についてもう少し見てみることにしよう。やや話が脱線してきたが、せっかくなのでキリのいいところまで深掘りして確認してみる。

kvm_set_pic_irqは、KVM_CREATE_IRQCHIPで初期化したkvm->arch.vpicを利用して、kvm_pic_set_irqを呼び出しているのみである。

static int kvm_set_pic_irq(struct kvm_kernel_irq_routing_entry *e,

struct kvm *kvm, int irq_source_id, int level,

bool line_status)

{

struct kvm_pic *pic = kvm->arch.vpic;

return kvm_pic_set_irq(pic, e->irqchip.pin, irq_source_id, level);

}

さて、kvm_pic_set_irqの実装を見にいくと以下のようになっている。

int kvm_pic_set_irq(struct kvm_pic *s, int irq, int irq_source_id, int level)

{

int ret, irq_level;

BUG_ON(irq < 0 || irq >= PIC_NUM_PINS);

pic_lock(s);

irq_level = __kvm_irq_line_state(&s->irq_states[irq],

irq_source_id, level);

ret = pic_set_irq1(&s->pics[irq >> 3], irq & 7, irq_level);